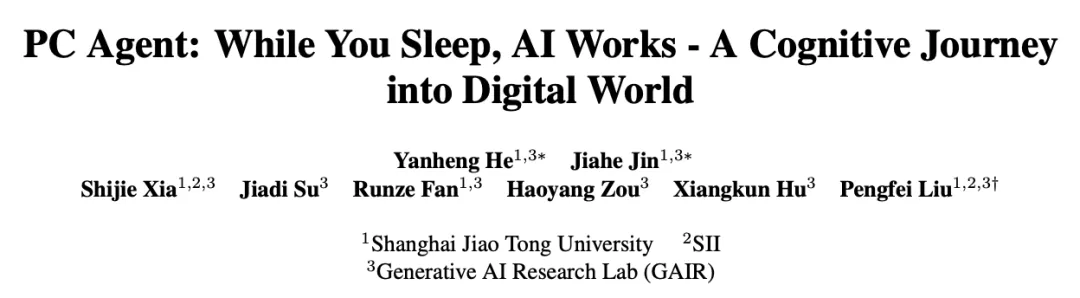

本文共同第一作者为上海交通大学 ACM 班的三年级本科生何彦衡,金嘉禾,两人均为 GAIR 实验室成员,指导老师为刘鹏飞副教授。上海交通大学生成式人工智能实验室 (GAIR Lab)的主要研究方向为:大模型的复杂推理,大模型预训练中的数据工程,多模态大模型,以及智能体。实验室主页:https://plms.ai/

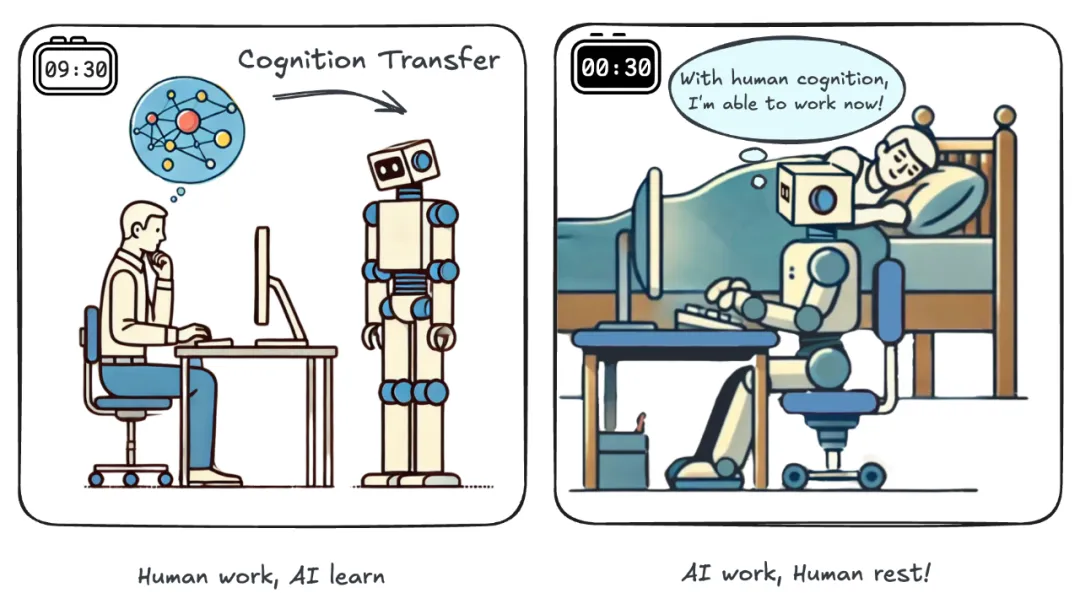

想象这样一个场景:深夜 11 点,你已经忙碌了一天,正准备休息,却想起明天早上还得分享一篇经典论文《Attention Is All You Need》,需要准备幻灯片。这时,你突然想到了自己的 AI 助手 —— PC Agent。你告诉它演讲的要点以及 PPT 要保存的地方,然后就安心睡去。第二天醒来,一份内容完备、制作精美的 PPT 已经在电脑中准备妥当。

这个听起来如同科幻的场景,已经被上海交通大学 GAIR 实验室的研究者们变成了现实!他们提出认知迁移的方法,通过高效收集人类认知轨迹,打造(训练,非 API 调用)了能够像人类一样阅读电脑屏幕,精准操控键盘鼠标,执行长达数十步、跨软件的复杂生产任务的 PC Agent,标志着 AI 真正为人类减负的重要一步!

Sam Altman 说,比起让智能体「订一家餐厅」,真正有趣的是让它「咨询 300 家餐厅」来找到最符合的口味。这样大量重复性的工作,对 PC Agent 而言也不在话下。比如,它可以一口气为多位图灵奖得主分别制作海报:

此外,PC Agent 也能轻松对标类似 Claude 3.5 Sonnet 的演示任务 —— 展现 “AI 调用 AI” 完成工作的巧妙设计。视频展示了它如何为自己创造一个网站:

- 论文标题:PC Agent: While You Sleep, AI Works – A Cognitive Journey into Digital World

- 论文地址:https://arxiv.org/pdf/2412.17589

- 代码地址:https://github.com/GAIR-NLP/PC-Agent

我们需要真正能为人类减负的智能体

数字智能体的革命性时刻

近期,Claude 3.5 Sonnet 的升级吸引了整个领域的目光。与 Siri 等依赖后端 API 调用的传统智能助手不同,它能根据用户指令,像人一样操控电脑,解读计算机屏幕,执行键盘鼠标操作。这种拟人的 GUI 前端交互模式具有高度通用性,赋予 AI 几乎无限的可能。

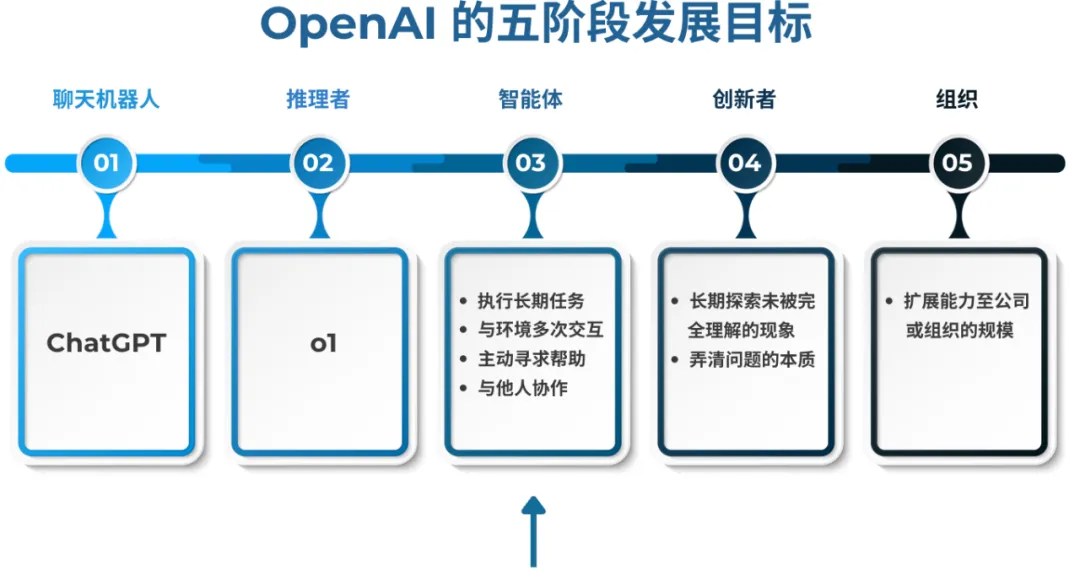

两年以来,随着大语言模型的突破性进展,AI 已经实现了一个又一个里程碑,但依然局限于对话窗口,而无法迈入真实世界工作。我们需要让智能体切实减轻人类的负担,迈向 OpenAI 通往 AGI 五级目标中的第三级。

关键性挑战

然而,当下智能体的电脑使用能力依然远逊色于人类,并未达到真正能为人类减负的水平,对开源社区来说更是如此。团队指出了两个关键的技术挑战:深度的电脑理解认知与精准的视觉定位能力。

1. 视觉定位:GUI 交互的基础

为了像人类一样使用电脑,智能体需要能为鼠标操作输出精确的坐标,视觉定位 —— 即精准定位元素(如 “最小化” 按钮)位置的能力,成为了 GUI 交互的基础。

然而,目前绝大多数的视觉语言模型,包括最先进的 GPT-4o,仍缺乏这一基本能力。近期有些研究试图通过在大规模 GUI 视觉定位数据集上微调模型来解决此问题,但这种办法往往牺牲了模型的通用能力。

2. 认知理解:胜任复杂任务的关键

即使具备了基础的视觉定位能力,当前模型依然无法胜任真正复杂的任务。团队认为,关键在于模型缺乏对电脑使用的认知理解。这体现在两个方面:

・缺乏细粒度的电脑操作知识

例如,为了在 PowerPoint 中添加标题,需要先点击文本框再输入。这对人类来讲非常直观,却能难倒目前的智能体。细粒度电脑操作知识的缺乏要求我们从人类认知的角度补充训练数据,因为 GUI 是为人类而设计的。

・缺乏智能体导向的训练

现有大语言模型展现出强大的能力,但未能完美胜任智能体工作流的需求,包括在长过程中充分关注上下文,根据变化的环境做出决策,并根据反馈调整策略。虽然提示工程可以在一定程度上弥补这一差距,但实现真正强大的智能体还需要专门的训练。

认知迁移 (Congition Transfer)

AI 从对话窗口到数字世界的关键道路

面对认知理解的挑战,团队提出人类认知迁移的方法,包括首个高效采集大规模人机交互数据的轻量级工具和从原始交互数据重建背后人类认知的完整流水线。通过开源相关代码,团队希望加速整个社区对数字智能体的研究进展。

具体来说,他们 1)首先采集人类使用电脑的原始操作轨迹,2)然后使用大模型重建无法被采集的人类认知 ,最终得到包含人类认知的交互轨迹(Cognitive trajectory)。通过模仿学习人类认知轨迹,AI 不仅能够模仿具体的动作,还能学习动作背后人类对电脑使用的认知理解。

初步实验表明,仅在 133 条认知轨迹数据上训练,PC Agent 就能够学会执行高达 50 步的复杂任务,极大证明了人类认知迁移方法的高效性。

一、首个高效采集大规模人机交互数据的轻量级工具

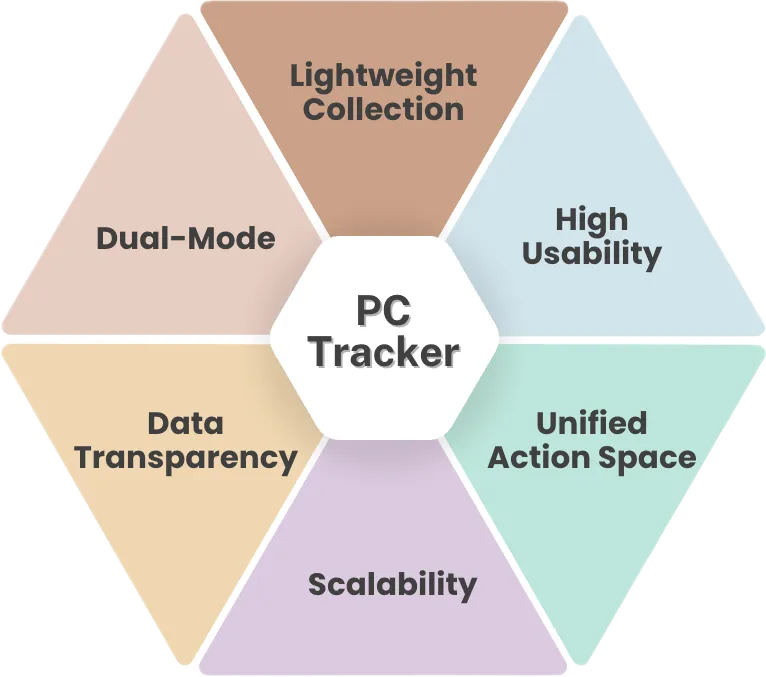

团队破解了一个阻碍智能体发展的关键瓶颈:训练数据的稀缺。他们开发了首个高效采集人机交互数据的轻量级工具 —— PC Tracker,旨在通过大规模收集真实人类动作轨迹来应对这一数据挑战。

类似于屏幕录制,PC Tracker 在后台运行,通过监控键盘和鼠标的活动来记录用户动作,同时捕捉屏幕截图以记录状态观察。

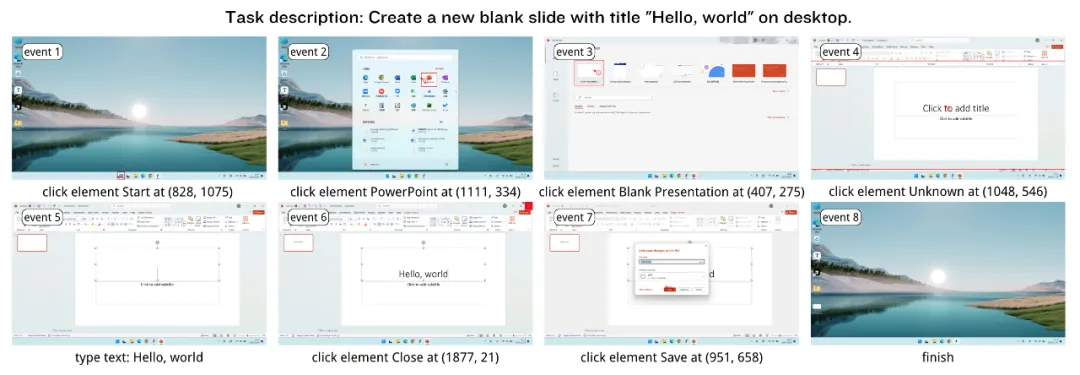

下面是 PC Tracker 采集的轨迹的示例:在桌面上创建一个标题为 “Hello,world” 的幻灯片。

具体而言,PC Tracker 具备以下关键特性:

1. 轻量级数据采集

不同于冗余的录屏方案,PC Tracker 仅捕捉关键事件 —— 仅当用户动作发生时,才会触发记录,从而减小存储开销。

2. 无损用户体验

PC Tracker 在后台运行,在持续记录的同时不会影响用户体验。软件不会记录可访问树,因为爬取过程会引入明显的延迟,干扰用户操作。而且随着视觉语言模型的发展,团队认为可访问树信息对未来模型不再必要。

3. 大规模数据采集

轻量级采集与无损用户体验的设计确保了大规模长期部署的可行性,使得 PC Tracker 支持无限规模的人机交互数据收集。团队统计表明,一小时的电脑使用即可产生约 2000 个事件,展现出巨大的数据潜力。

4. 统一动作空间

PC Tracker 支持一个为 AI 设计的统一动作空间,人类原始的离散键鼠操作会被合并封装成如双击、输入(type)等更具语义信息的动作。

5. 双采集模式

PC Tracker 支持任务(task oriented)和无任务 (non-task oriented) 两种采集模式。无任务模式记录用户自由的交互轨迹,非常适合长期、大规模的数据收集;而任务模式记录用户完成特定任务的交互轨迹,主要用于监督微调的数据标注。

6. 数据透明与隐私

所有记录数据均在用户本地存储并提供 Markdown 可视化文件,用户也可以在采集过程中方便控制记录的终止以及数据的丢弃,以确保隐私。

二、从原始交互数据重建认知轨迹

人类行为是大脑认知活动的外在投射。在使用电脑时,我们的脑中经历了自然的认知活动过程,包括对历史进展和当前状态的分析,作出下一步决策的推理等。这一思考过程蕴含了人类对电脑使用的认知,但大脑活动无法被直接记录。为此,团队利用大模型分两阶段对轨迹数据进行认知重建:

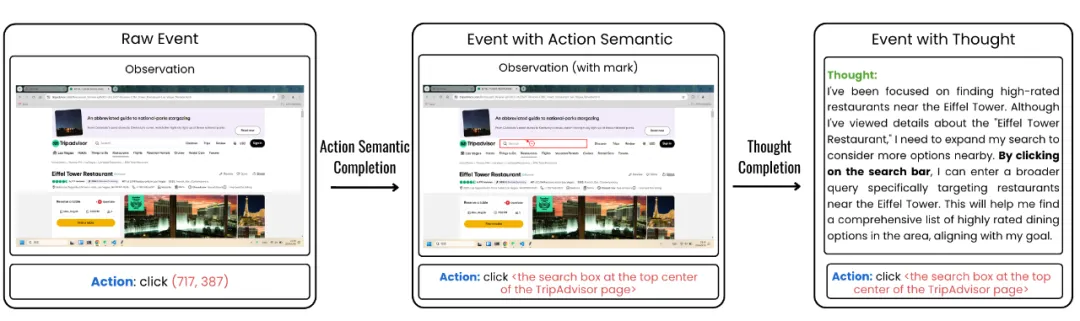

1. 动作语义重建

原始点击动作仅包括数值坐标位置,与其他动作(如键盘输入)相比缺乏直接的语义信息,因此首先进行的处理是点击动作的语义信息重建。具体而言,这一步为点击的目标生成了自然语言描述,如下图所示为点击位置 (717, 387) 生成描述 “TripAdvisor 网站上方中部的搜索框”。

2. 思考过程重建

利用轨迹数据中的上下文信息和补全的动作语义,团队迭代提示大模型生成每步动作背后的思考过程。如图所示,人类动作 “点击 TripAdvisor 网站上方中部的搜索框” 背后的思考过程被成功重建:“我想要找埃菲尔铁塔的高分餐厅,虽然已经查看了关于 “埃菲尔铁塔餐厅” 的信息,但需要扩大搜索范围。通过点击搜索框,我可以输入一个更广泛的查询……”

三、构建能够完成复杂任务的数字智能体

基于对当前智能体面临的主要挑战(视觉定位与认知理解)的深刻理解,团队分别提出解决方案,打造了一个能够完成真正复杂任务的 PC Agent:

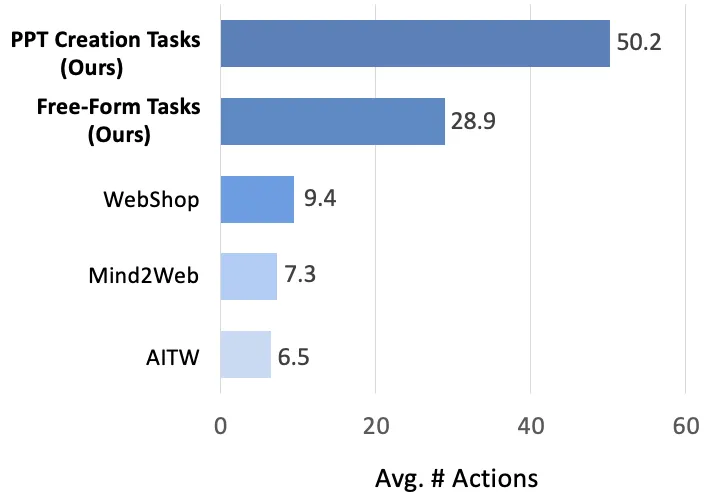

1. 以认知轨迹训练规划智能体

使用 PC Tracker 采集并重建认知后得到的认知轨迹,是训练智能体的高质量数据。团队选择了 PPT 制作(包括上网收集资源)这一综合任务作为初步实验场景,仅在 133 条认知轨迹上训练以验证其数据效率。这些轨迹分为自由(使用 Chrome 和 PowerPoint)任务与 PPT 制作任务两类,动作数量明显高于现有公开轨迹数据,如下图所示。

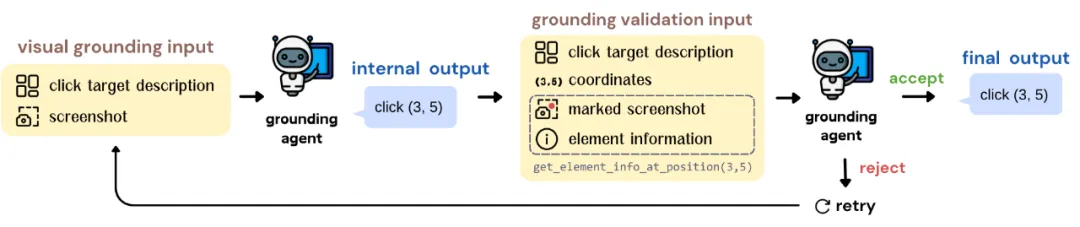

2. 通过自我验证实现精准视觉定位

团队发现,Ai2 近期发布的开源通用视觉语言模型 Molmo,通过引入创新的指令微调数据 Pixmo,展现了良好的视觉定位能力。因此,团队将其作为视觉定位智能体的基础模型。然而,Molmo 仍会偶尔出现定位偏差,而操作电脑时微小的点击错位也可能导致灾难性后果,如不慎关闭浏览器 —— 当前的智能体很难从这些错误中恢复。

团队提出了一种创新方法,进一步增强其视觉定位能力,几乎能达到人类的完美水平:Molmo 可以借助来自系统接口的外部反馈,自我验证其视觉定位的准确性。如下图所示,定位智能体会先根据点击目标描述生成一个初步的坐标,然后从系统接口中获取该坐标对应的元素信息,判断是否与目标描述匹配。如不匹配,定位过程将重新进行。

3. 多智能体协作

在 PC Agent 的初步实现中,为了更好的利用现有模型的能力,团队采用了一个多智能体架构。其中,规划智能体负责动作决策,视觉定位智能体负责点击动作执行。值得指出的是,此系统完全基于开源模型构建。

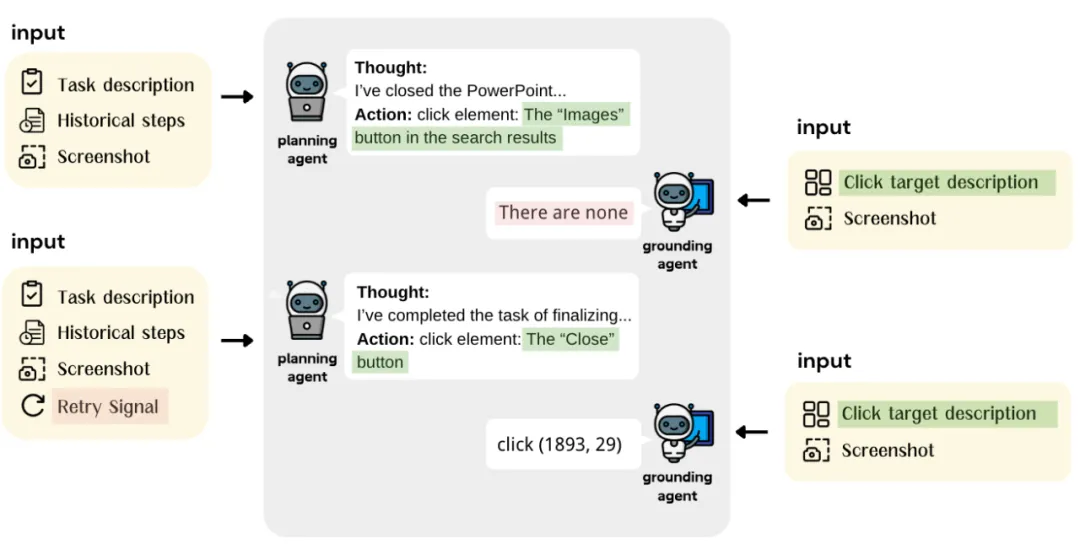

具体来说,两个智能体如此协作:规划智能体首先分析任务并观察状态,以作出动作决策。非点击相关动作将被直接执行,而对于点击相关动作,规划智能体生成的点击目标描述将被转发给视觉定位智能体,由其生成具体坐标。如果它发现目标在屏幕上不存在,将提示规划智能体重新决策。具体的动作执行将调用 pyautogui 函数完成。下图为一个协作的示例。

结论与展望

团队提出了一种创新的认知迁移框架,包括首个高效采集人机交互数据的工具 PC Tracker 和完整的认知重建过程,并初步验证了方法的高效性。PC Agent 在 PPT 制作场景下展示了执行复杂长程任务的能力,标志 AI 真正为人类减负迈出的重要一步。

展望未来,团队确定了几个重要的研究方向:

1. 大规模泛化实验:尽管已在有限的训练数据下初步实验,但泛化能力的验证仍需跨软件和跨任务的更大规模实验。

2. 长程规划与鲁棒性:OpenAI o1 所展现的推理与自我纠错能力,为在长序列中实现鲁棒操作提供了有力支撑。在面对复杂任务时,如何保持行动与目标的一致性,以及如何建立更加完善的纠错机制,仍是亟待深入讨论的问题。

3. 无任务数据的利用:PC Tracker 可以在不限制特定任务的情况下提供近乎无限规模的自然人机交互数据,这些数据包含了丰富的人类一般操作策略与行为偏好信息,可应用于预训练、监督微调和强化学习等多个场景。探索有效的方法来利用这些数据是重要而有前景的方向。

4. 动作空间优化:针对拖拽等复杂鼠标操作的特殊挑战,需要开发更精确的空间关系理解机制,并优化数据收集策略。

5. 复杂任务的评估:当前对数字智能体的评估基准主要关注基础任务的成功率。然而,对于像 PPT 制作这样的真实世界复杂任务,我们需要更加全面的评估框架,不仅关注任务成功率,还要考虑完成质量、专业性等多维度指标。

文章来自:51CTO