这两年大模型的“推理能力”已经从一个炫技名词,变成衡量模型上限的关键维度。无论是数学解题、代码推导,还是多步逻辑判断,只要你想让模型认真思考,几乎绕不过一个关键词,Chain-of-Thought,也就是大家熟悉的 CoT,“一步一步想,一步一步写出来”。

CoT的成功已经被无数论文、产品和 demo 反复证明,只要把“请详细说明推理过程”加进提示词,模型的答题正确率往往肉眼可见地提高。它不再只是给你一个结果,而是把过程摊开,让你看到它是怎么想的。对研究者来说,这既是能力提升,也是某种“可解释性”的幻象。

但有一个问题,一直被大家默默忽略,所有这些工作,几乎都默认一件事——从头到尾,都是“同一个模型在推理”。从读题,到逐步分析,再到写出最终答案,都是同一个大模型一路跑完。可是在一个真实的 AI 系统里,这种“单模型闭门造车”的方式,真的合理吗?

如果我们不再把大模型当成一个孤立的“黑盒”,而是当成一个可以协作的“推理模块”,问题立刻变得有趣,一个模型写到一半的推理链,能不能交给另一个模型继续?一段 CoT 能不能像代码片段一样,被不同模型复用、延续、修正?

甚至,能不能有这样的系统,大模型负责“难段”,小模型负责“收尾”,从而在成本和性能之间找到新的平衡?这是我们今天要直面的问题——推理接力,是否可行?

“推理接力”背后,其实是三个更底层的关键词。第一是推理稳定性,当你中途换一个模型,原本展开的推理逻辑是否会崩塌?第二是模型间的互操作性,不同家族、不同规模的模型,是否说得上同一种“推理语言”?第三是多模型协作推理系统的可行性,未来的 AI,是否有可能像一个“推理团队”,而不是一个“孤胆专家”,通过接力、协作来完成复杂任务?

这项工作把问题挑明了,当一个模型的推理链被截断在四分之一、二分之一、四分之三处时,换一个模型来续写——到底能否无缝衔接?是顺势而下,还是直接翻车?

提出这个问题的,不是一家大厂内部技术报告,而是一个典型的“学术+工程”混合团队。前面三位第一作者来自传统学术阵地,宾夕法尼亚州立大学、纽约州立大学宾汉姆顿分校和多伦多大学,偏理论与方法论;后面几位作者则来自 加州大学伯克利分校和 Algoverse,一边是著名的 AI 重镇,一边是更偏工程与应用导向的机构。从组合上看,这是一个很典型的 2025 年式 AI 研究团队,上游有对推理本身的好奇,下游有对多模型系统可落地性的现实关注。

1.从 CoT 到 PRM,推理评估的范式转向

要理解这项研究,得先回到 CoT(Chain-of-Thought)刚被发现的那一刻——研究者惊讶地发现,只要让模型“把思考过程写出来”,它的数学和逻辑能力就会显著提升。CoT 让模型像人一样一步步推理,也让“写过程”成为大模型时代的默认提示词。

但 CoT 的发展很快走向更复杂的方向。自一致性(Self-Consistency)告诉我们,模型内部其实存在多条潜在推理路径,采样多条再投票,往往比单一路径更可靠。Least-to-Most 等结构化方法则进一步把复杂问题拆解成子问题,让推理变得更像“程序化思考”。

与此同时,研究者也开始怀疑,这些推理链到底有多可信?Lanham 等人的工作通过截断 CoT、让模型续写,揭示了一个尴尬事实——模型有时并不是在“延续逻辑”,而是在“顺着语气编下去”。这直接暴露了一个长期被忽略的问题,我们一直在用最终答案评估推理能力,却无法判断推理过程本身是否合理。

这正是 Process Reward Model(PRM)出现的意义。PRM 不再只看“答案对不对”,而是逐步评估每一步推理是否合理、是否推动问题向前。它把评估从“结果正确”带向“过程正确”,让推理链第一次成为可以被量化、被审视的对象。

在这样的背景下,这项研究提出了一个更进一步的问题,如果推理链本身可以被评估,那么它能不能被“传递”?不同模型之间能不能接力?CoT能不能从“模型内部的思维过程”变成“模型之间可共享的推理资源”?而 PRM,恰好提供了检验这场“推理接力赛”是否顺畅的标尺。

2.方法论,推理接力的三步框架

如果把这项研究看成一场关于“推理链能否跨模型流通”的大型实验,那么方法论部分就是它的操作手册。作者没有简单地把两个模型的输出拼在一起,而是设计了一套严谨又带点“工程美学”的流程,让推理链的生成、截断与接力都具备可控性和可复现性。

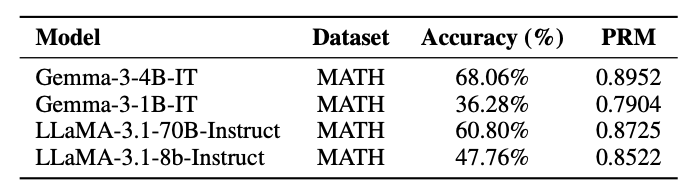

我们从两个“强力起跑手”开始。Gemma-3-4B-IT和 LLaMA-3.1-70B-Instruct 被选为推理链的初始生成者,它们负责从题目开始,一步一步写出完整的 Chain-of-Thought。这里的“完整”不仅指内容完整,还包括对每个 token 的 log-prob 记录。

log-prob 是模型在生成每个词时的内部置信度,它像一条隐藏的“心电图”,记录着模型在推理过程中的信心波动。通过这些信号,研究者能看到模型在哪些步骤特别确定,在哪些步骤犹豫不决。

有了推理链和信心曲线,第二步就是决定“在哪里切断”。传统做法可能会按token 数量或句子数量来截断,但作者选择了更贴近模型内部状态的方式,累积 log-prob。

他们把整条推理链的总 log-prob 当作一个整体,然后找到累积达到 25%、50%、75% 的位置,分别作为早期、中期和后期的截断点。换句话说,截断点不是“写了多少字”,而是“模型已经积累了多少自信”。这种基于“信心流”的截断方式,让推理链的阶段划分更贴近模型的真实推理节奏。

截断之后,第三步才是真正的“接力”。研究者把截断后的推理前缀与原题目重新组合成一个提示,输入给第二个模型,让它继续推理直到得出最终答案。接力选手分为两类,同族小模型(如 Gemma-3-1B)和跨族小模型(如 LLaMA-3.1-8B)。同族模型共享相似的架构、tokenizer 和训练风格,理论上更容易“接上话”;跨族模型则像是接手一个完全不同风格的草稿,能否读懂、能否延续,是这项研究最想回答的问题之一。

当第二模型完成续写后,前缀与后缀被拼接成一条完整的“混合推理链”(Hybrid CoT)。这条链既包含强模型的推理,也包含小模型的续写,是一种真正意义上的“多模型协作推理产物”。接下来,它们将被送上评估台,接受严格的质量检测。

3.实验设置:数据、模型与评估体系

为了让推理接力的实验更具说服力,作者选择了一个足够难、足够结构化、足够能体现推理链质量的数据集,MATH。这个包含 5000 道题目的数学推理数据集,覆盖代数、几何、数论等多个领域,每一道题都需要多步推理才能得出答案。它不仅是评估模型数学能力的标杆,也是检验推理链稳定性的理想场景。

在模型组合上,研究者采用了“强模型生成、弱模型接力”的策略。负责生成完整推理链的基座模型是 Gemma-3-4B-IT 和 LLaMA-3.1-70B-Instruct,它们的推理能力足够强,能提供高质量的起始链条。

而负责接力的则是它们的小型版本,Gemma-3-1B-IT 和 LLaMA-3.1-8B-Instruct。这样的组合既能测试同族模型之间的互操作性,也能观察跨族模型在接力时是否会出现逻辑断裂。

评估体系则是这项研究的亮点之一。最终答案准确率当然是最直观的指标,但作者显然不满足于“只看结果”。他们引入了 Process Reward Model(PRM)来对推理链的每一步进行评分,从而评估逻辑一致性与推理质量。PRM 的加入让评估从“结果导向”转向“过程导向”,这是理解推理链稳定性的关键。

除此之外,还有两个非常有洞察力的指标。NRG(Normalized Relative Gain)用于衡量接力是否带来性能提升,它告诉我们“接力有没有帮忙”。XMD(Cross-Model Degradation)则用于衡量接力是否破坏了原模型的推理链,它告诉我们“接力有没有添乱”。这两个指标让研究者能够更细致地分析不同模型组合、不同截断点下的推理表现。

4.实验结果:推理接力的成败与边界

研究团队把不同模型、不同截断点、不同家族的组合全部跑了一遍,结果呈现出一种非常鲜明、甚至可以说是“泾渭分明”的趋势,同族模型之间的接力顺滑自然,跨族模型之间的接力则充满磕绊。推理链,看似只是文本,但背后其实藏着模型之间深层的“思维风格差异”。

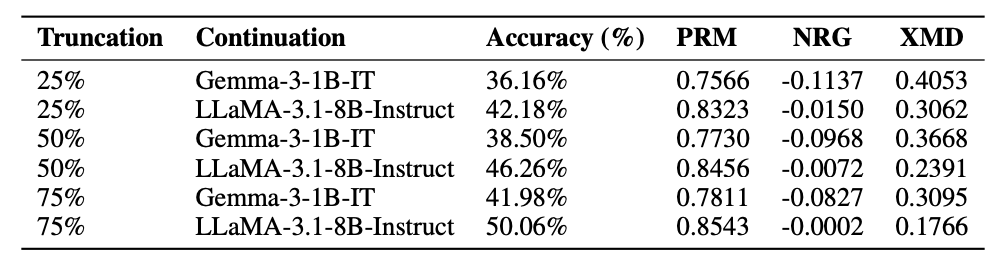

先看最顺利的部分,同族模型接力。无论是 Gemma → Gemma,还是 LLaMA → LLaMA,只要是同一家族内部的“兄弟模型”接棒,整体表现都相当稳健。

随着截断点从 25% 推进到 50%、再到 75%,准确率呈现出一种非常自然的上升趋势,仿佛模型越往后接,越能“读懂前任留下的草稿”。与此同时,XMD(跨模型退化指标)也在不断下降,说明接力过程中对原推理链的破坏越来越小。

图片

图片

表1:MATH数据集上每个模型完全生成的推理链的性能(即,没有与另一个模型的切换或交换)。

这种现象背后其实很好理解。同族模型共享相似的 tokenizer、相似的预训练语料、相似的推理结构偏好,它们的“推理语言”天然更接近。就像你接手一个同事写的代码,如果你们用的是同一套框架、同一套命名习惯、同一套工程规范,那你自然能更快读懂、也更容易继续写下去。推理链也是同样的道理。

图片

图片

表2:使用Gemma3-4B-IT中完全生成的CoT,在MATH数据集上按截断点和连续模型划分的混合推理链的性能。

但一旦跨族接力,画风立刻变了。无论是 LLaMA → Gemma,还是 Gemma → LLaMA,准确率都出现明显下降,NRG(相对增益)不是负数就是远低于同族组合,XMD 更是居高不下,几乎在告诉你,“这条推理链被续写得面目全非了。”

跨族接力的失败并不是偶然,而是结构性的。不同架构的模型在推理时使用的“内部表征语言”并不相同,它们的逻辑展开方式、句式偏好、数学表达习惯、甚至 token 切分方式都可能完全不一样。

图片

图片

表3:使用LLaMA-3.1-70B-Instruct中完全生成的CoT,在MATH数据集上按截断点和连续模型划分的混合推理链的性能。

你可以把它理解成,Gemma 写的是“中文式数学解题步骤”,LLaMA 写的是“英文式数学解题步骤”,两者的风格差异足以让对方看不懂彼此的“思维轨迹”。于是,当一个模型接手另一个模型的推理链时,它往往不是“延续”,而是“重新开始”,这自然导致逻辑断裂、语义不连续,最终体现在准确率和 XMD 上,就是一片惨淡。

不过,即便是跨族接力,也不是完全没有规律可循。一个非常稳定的趋势是,截断越晚,接力越稳定。到了 75% 截断点时,无论是同族还是跨族,表现都比 25% 和 50% 时好得多。这很好理解,越靠近推理末尾,剩下的步骤越少,逻辑结构越明确,模型需要“理解”的上下文越短,犯错空间也越小。

但即便如此,75% 截断的接力表现仍然明显低于原模型完整 CoT 的表现。这说明推理链的后段并不是独立存在的,它依赖前段的风格、结构和逻辑铺垫。推理链不是一串可以随意拼接的句子,而是一种“风格化的逻辑结构”。只要前后风格不一致,哪怕只剩最后几步,也可能出现偏差。

PRM的结果进一步揭示了跨族接力的深层问题。跨族模型的PRM 分数普遍低于同族模型,这意味着它们不仅在最终答案上表现不佳,在推理过程本身的逻辑一致性上也出现了明显断裂。PRM 的评分机制本质上是在问,“你这一步推理是否合理?”而跨族模型往往在续写时出现逻辑跳跃、语义不连贯、步骤不推进等问题,说明它们确实难以理解前者的推理“语法”。

5.推理接力为何难?模型协作的未来在哪里?

看到这里,一个问题自然浮现,为什么推理接力这么难?为什么模型之间不能像人类一样,轻松接手彼此的思考过程?

最根本的原因,是推理风格与表征差异。不同模型的推理链看起来都是自然语言,但背后依赖的是各自的内部表征空间。Gemma 的“推理语言”和 LLaMA 的“推理语言”并不相同,它们的逻辑展开方式、表达偏好、token 切分方式都可能完全不同。你让一个模型接手另一个模型的推理链,本质上是在让它“翻译”一种它从未真正学过的推理语法,这当然容易出错。

另一个关键因素是上下文整合负担。小模型接手大模型的长推理链,就像一个初级工程师接手资深工程师写的复杂代码。即便逻辑是对的,它也可能因为理解负担过重而无法顺利延续。尤其是在数学推理这种高度结构化的任务里,前面几步的逻辑铺垫往往决定后续步骤的可行性,小模型一旦理解不到位,后续推理就会迅速崩塌。

错误放大也是一个不可忽视的因素。推理链是一种累积结构,前面的小偏差会在后续步骤中被不断放大。跨族模型由于风格差异更大,更难纠正前者的错误,于是错误会像滚雪球一样越滚越大,最终导致推理链彻底偏离轨道。

尽管如此,推理接力的潜在价值依然巨大。想象一下未来的 AI 系统,大型模型负责关键推理节点,小模型负责收尾或执行重复性步骤,整个系统像流水线一样协作完成复杂任务。这不仅能降低推理成本,还能让 AI 系统具备更高的灵活性和可扩展性。推理接力的研究,正是在为这种“模块化推理系统”探索可行路径。

推理接力不是为了证明“模型能不能接力”,而是为了回答一个更重要的问题,未来的 AI 系统,能不能像一个团队,而不是一个孤立的个体,去完成复杂推理任务。

参考资料:https://arxiv.org/abs/2512.20647

文章来自:51CTO