本文转自AI科技评论

作者 | 陈彩娴

编辑 | 青暮

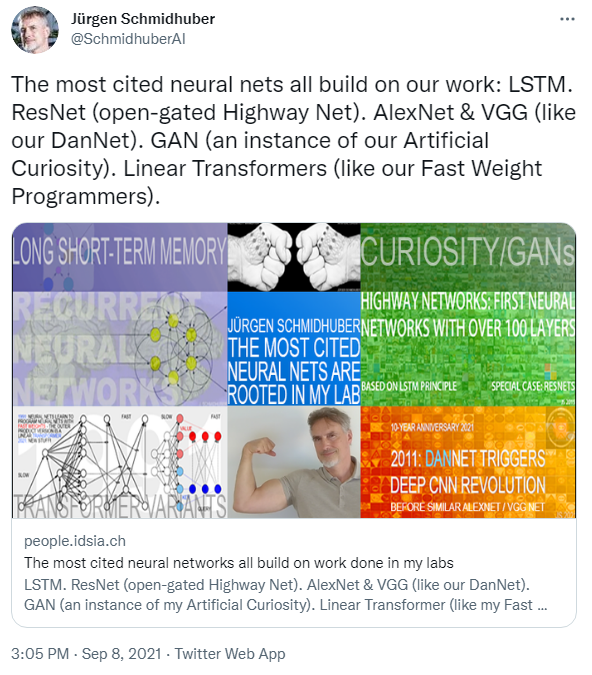

昨晚,“递归神经网络之父”Jürgen Schmidhuber 在推特上亲自发文,称目前引用数最高的5项神经网络工作都基于他的团队成果,一时引起了网友的广泛讨论。这并不是他首次发声,Jürgen Schmidhuber近两年来发表无数文章和言论,每次提及几项他过去的研究,表示是他首创,并抱怨学界不承认他对AI领域的贡献。

这篇博文也算是为我们划了重点,即他过去两年来提过的几十项“不是你首创”AI研究中,有哪些更具影响力。

Jürgen 称,人工神经网络(neural networks,简称“NN”)与深度学习是现代人工智能的两大主题,而现今最受欢迎的五大神经网络都是基于他在慕尼黑工业大学和 IDSIA 实验室的研究团队所取得的成果,这五大神经网络就包括:

1)LSTM(Long Short-Term Memory,长短期记忆人工神经网络),是 20 世纪被引用最多的神经网络;当然这项工作已经被公认是他的首创,Yann LeCun也在自传中提及了这一点;

2)ResNet,21世纪被引用最多的神经网络,Jürgen 认为是他们早期提出的高速网络(Highway Net,第一个真正有效的深度前馈神经网络)的门控版本;

3)AlexNet 与 VGG Net,21世纪引用数排第二与第三的神经网络,Jürgen 称这两个网络都是基于他们早期提出的 DanNet(第一个在图像识别竞赛中取胜的深度卷积神经网络);

4)GAN(Generative Adversarial Networks,生成对抗网络),基于他早期提出的“对抗性人工好奇心”(Adversarial Artificial Curiosity);

5)Transformer的变体,Jürgen 认为,线性 Transformer 的形式与他早期所提出的 Fast Weight Programmers 一样。许多工作是从他们在 1990 年至 1991 年间提出的 Annus Mirabilis 开始的,当时的计算代价比现在要贵一百万倍。

回顾神经网络的发展历程,Jürgen 所提出的五大工作都在现代人工智能领域的研究中发挥了重要作用。比如,LSTM 被广泛应用于医疗健康、学习机器人、游戏、语音处理与机器翻译等研究方向。

在他所发表的博文中,Jürgen 本人特地谈到,何恺明等人在2015年所提出的 ResNet(残差网络)借鉴了他们在 2015 年 5 月发布的 Highway Net。他指出,Highway Net 是第一个具有 100 层以上的前馈神经网络(以前的神经网络最多只有几十层),而 ResNet 的本质其实是“开放的” Highway Nets。Highway Net 展示了具有跳跃式传递(skip connection)的深度神经网络是如何工作的,且在 ImageNet 上的表现与 ResNet 大致相同。但美国专利商标局在 2001 年就将这项发明的专利授予了 NNAISENSE。

论文链接:https://arxiv.org/pdf/1505.00387.pdf

值得注意的是,20 世纪与 21 世纪被引用最高的神经网络(LSTM与ResNet)是紧密相连的,因为 Highway Net 实际上是 Jürgen 团队所提出的循环 LSTM 的前馈神经网络版本。深度学习主要是聚焦于神经网络的深度。LSTM 打破了监督循环神经网络的深度局限性,而 Highway Nets 将其引到了前馈神经网络。

在 Jürgen 所写的文章中,他感慨,这些工作为谷歌、Facebook、微软等大企业做出了巨大贡献,颇有点“为他人做嫁衣”的唏嘘:何恺明是在 MSRA 期间发表的 ResNet,后来他加入了Facebook;而 AlexNet 与 VGG Net 的大多作者去了谷歌,谷歌在 2017 年发布了Transformer,都与他在 1991 年发表的线性 Transformer 相关,然后谷歌还收购了他实验室里一位学生参与联合创立的 DeepMind;而 DanNet 的二作、GAN 的一作去了苹果公司。

“上述这些公司都广泛使用了我的 LSTM。”

或许是抱怨过于频繁,Jürgen Schmidhuber形象早已濒临崩塌边缘。

广大吃瓜群众亦不耐烦,在推特和reddit上纷纷对Jürgen Schmidhuber开启了嘲讽模式,一句“他的自负大于他的引用次数”可谓精辟。

在Reddit上,一位网友中肯地评价道:

不可否认,他做了真正开创性的工作,并帮助开创了深度学习,但这篇文章看起来像一个孩子在大喊,“看我,我是最棒的”。

![]()