最近一周,AI领域真的是疯狂。

GPT-4、Microsoft 365 Copilot、Midjourney V5、Google PaLM API、百度文心一言等等,这些AI产品像一颗颗的炸弹,扎堆在这周引爆。

而近日,还有机构预测称,这种AI的推出,未来或影响全美国80%的工作岗位,那么放大到全球来看,会影响多少?

而在这场AI大乱斗之下,谁是最后赢家可能还无法预测,但目前,已经有一个大赢家诞生了,那就是GPU芯片厂商Nvidia。

AI的背后其实是算力,特别是GPU芯片,之前OpenAI已公布过具体的信息,在训练上一代的GPT-3时,使用了数千个NVIDIA V100 GPU。

而调研机构TrendForce的数据,显示GPT-3训练时大概用到了20000个NVIDIA A100 GPU左右的算力,而ChatGPT商业化后所需的GPU数量将达到30000个以上。

之后随着模型的不断升级,需要用到的GPU芯片会越来越多,呈倍数增长,那么Nvidia的GPU显卡会越卖越多。

不只是OpenAI,像谷歌、微软等等推出的AI产品,均需要GPU芯片啊,这是一笔多大的生意?

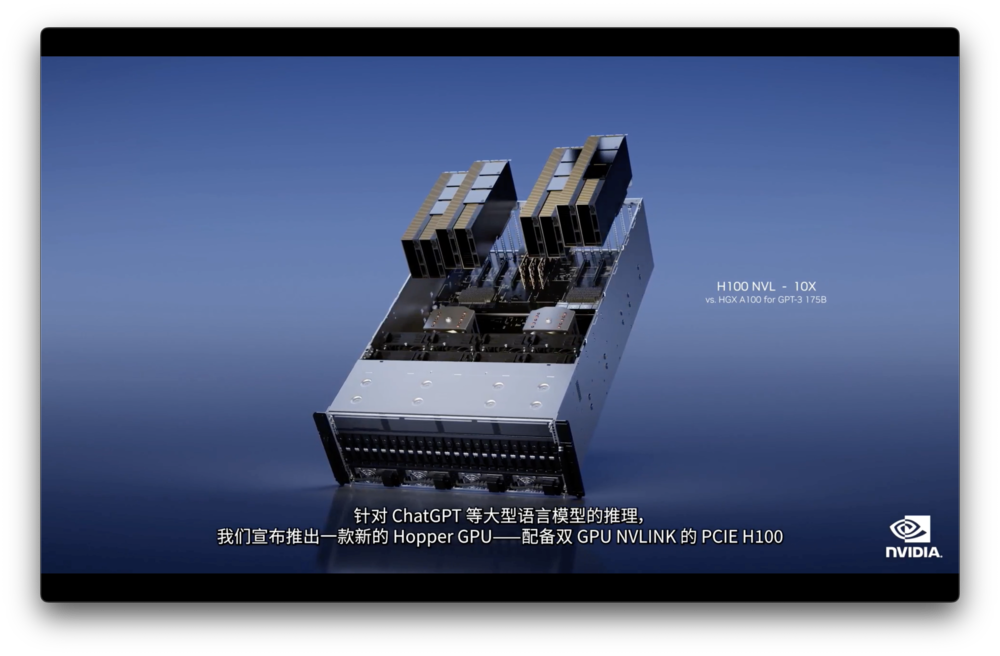

而为了更好的服务于AI,Nvidia发布了全新的GPU推理平台,该平台包括4种不同配置,L4 Tensor Core GPU、L40 GPU、H100 NVL GPU和Grace Hopper超级芯片。分别对应了AI视频加速、图像生成加速、大型语言模型(LLM)加速和推荐系统和LLM数据库。

拿专门为LLM设计的GPU–H100 NVL来说,Nvidia表示相比于英伟达HGX A100,一台搭载四对H100和双NVLINK的标准服务器速度能快10倍。

而L4 Tensor Core GPU,是AI生成视频的通用GPU,Nvidia表示,使用它可以提供比CPU高120倍的性能……

事实上,反映在资本市场,Nvidia也确实赢麻了,2023年以来,还不到3个月,nvidia的股价已经涨了80%左右,市值涨了近3000亿美元,相当于2万亿元人民币。

不管最后是谁家的AI胜出,谁家的AI倒下,与Nvidia都关系不大,反正Nvidia的GPU显卡,已经立于不败之地,出货量已经节节攀升了。

![]()