“类人智能体”一直是一个令人着迷的目标。

人们不仅希望智能体能够完成任务,更希望它们的行为方式接近人类,展现出自然、可信的动作与决策。这种追求不仅关乎技术性能,更关乎可解释性与社会接受度。

人类风格智能体的意义在于,它们能够在与人类交互时减少违和感,让人们更容易信任和理解其行为。

无论是在机器人操作、虚拟助手,还是游戏对战中,一个动作流畅、符合人类习惯的智能体,往往比一个仅仅追求高分或效率的智能体更具价值。

这一目标与图灵测试的精神高度契合。

图灵测试的核心并不是考察智能体是否能解决复杂问题,而是能否在行为和交流中“以假乱真”,让人类无法轻易区分其与真实人类的差别。类人智能的长期目标,是让AI不仅聪明,而且“像人”。

然而,现实中的强化学习智能体虽然在许多任务上已经超越人类,比如在围棋、电子游戏或机器人控制中取得了超人表现,但它们的行为往往缺乏自然性。

常见的问题包括动作不平滑、导航方式怪异、甚至出现抖动或旋转等“非人类”行为。这些现象让智能体在完成任务时显得机械而僵硬,难以获得人类的直觉认同。

现有的研究尝试过几种方法来解决这一问题。其一是基于规则的约束,通过人为设定惩罚机制来避免非人类动作,例如对旋转、抖动等行为加以惩罚。但这种方法需要大量人工设计,成本高昂且难以推广。

另一种方法是模仿学习,通过直接学习人类演示来提升智能体的类人性。然而模仿学习的效果高度依赖演示数据的质量,往往在性能与人类风格之间难以兼顾。

因此,核心挑战在于如何在保持任务成功率的同时,让智能体展现人类般的行为?这不仅是技术问题,更是AI可信度与社会接受度的关键。

本研究由中国台湾的两大顶尖学术机构联合完成。主要作者来自国立阳明交通大学(NYCU)计算机科学系,该校在人工智能、强化学习与机器人控制领域有深厚积累。团队成员包括博士生与青年研究人员,负责方法设计、实验实现与数据分析。

1.理论基础与相关工作

要理解这篇研究的创新点,首先需要回到“类人强化学习”的基本脉络。

过去的研究大致可以分为两条路径:一是通过行为约束来避免智能体出现不自然的动作,二是直接从人类演示中学习,试图让智能体模仿人类的行为模式。

在行为约束的路径上,研究者通常会引入额外的惩罚机制。例如,当智能体出现旋转、抖动等明显“非人类”的动作时,就会被施加负奖励。

这种方法的优点是直观有效,但缺点也很明显:需要大量人工设计规则,且难以覆盖所有可能的非人类行为。换句话说,这是一种“硬编码”的方式,成本高昂,灵活性不足。

另一条路径是模仿学习。通过收集人类演示数据,智能体可以直接学习人类的动作序列,从而在行为上更接近人类。模仿学习的代表方法包括行为克隆(Behavior Cloning)和逆强化学习(Inverse RL)。

它们的共同点是依赖人类演示来构建学习目标。然而,这种方法的局限在于:演示数据的质量决定了智能体的上限。如果演示数据有限或不够精细,智能体往往难以在复杂任务中保持高性能。

为了突破这些限制,研究团队引入了半马尔可夫决策过程(Semi-Markov Decision Process, SMDP)的概念。与传统的马尔可夫决策过程(MDP)不同,SMDP允许智能体在一个状态下执行一段连续的动作序列,这段序列被称为“宏动作”。

宏动作的定义很简单,它是一组连续的动作片段,例如在机器人控制中,一个“推门”的宏动作可能包含多个连续的手臂动作。

宏动作的优势在于它降低了智能体的决策频率。相比逐步选择每一个原子动作,智能体可以一次性选择一个宏动作,从而更好地捕捉长时依赖关系。

这不仅提升了规划效率,也让智能体的行为更接近人类,因为人类在执行任务时往往也是以“动作片段”为单位,而不是逐步计算每一个细微动作。

在实现宏动作的过程中,研究团队采用了向量量化变分自编码器(Vector-Quantized Variational Autoencoder, VQVAE)。VQVAE的核心思想是将连续的潜在空间离散化,学习出一组有限的“码本”。

每一个码本条目代表一种潜在的宏动作模式。通过这种方式,复杂的连续动作空间被转化为结构化的离散空间。

这种离散潜在空间的学习有两个关键好处。首先,它让智能体在训练过程中能够更高效地搜索动作空间,因为不再需要在无限的连续空间中探索,而是只需在有限的码本中选择。其次,它保证了智能体的动作结构更接近人类演示,因为码本本身是从人类数据中提炼出来的。智能体的每一个动作选择,都被约束在“人类风格”的轨迹流形之中。

2.方法框架:Macro Action Quantization (MAQ)

要让强化学习智能体真正展现人类风格,研究团队提出了一个全新的框架——宏动作量化(Macro Action Quantization, MAQ)。

图1:MAQ的整体培训过程。(1)人类行为蒸馏:对状态(st)和宏观动作(mt=(at,at+1,…,at+H−1))训练条件VQVAE,以学习离散码本;通过动作轨迹上的滑动窗口从人类演示中提取宏观动作(mt)。(2)MAQ强化学习:在线策略(πθ)通过选择码本索引在学习的离散码空间中起作用,VQVAE将码本索引解码为在环境中执行的宏动作。

它的核心思想是将人类风格定义为一个轨迹优化问题,并通过滚动时域控制(HRC)在短片段内进行动作优化,让智能体的行为既能完成任务,又能保持自然流畅。

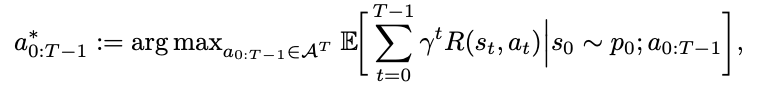

在传统的强化学习中,轨迹优化通常被表述为:

图片

图片

这里,智能体需要在整个时间范围 TT 内寻找最优动作序列。然而,这种全局优化在复杂任务中往往不可行。于是,研究团队引入了滚动时域控制(HRC),在短片段内进行优化:

图片

图片

这种方法让智能体在每个决策点只需考虑长度为 HH 的动作序列,并不断滚动更新,从而在保持反应灵活性的同时,生成更自然的动作轨迹。

为了让这些短片段真正具备人类风格,MAQ引入了宏动作量化流程。首先是人类行为蒸馏:研究团队利用条件VQVAE(Vector-Quantized Variational Autoencoder)从人类演示中提取宏动作,并建立一个离散的动作码本。

每个码本条目代表一种可能的宏动作模式,相当于把人类的行为片段“编码”成可供智能体选择的离散单元。

接下来是动作空间的转化。通过宏动作的引入,原本的马尔可夫决策过程(MDP)被转化为半马尔可夫决策过程(SMDP)。这意味着智能体不再在原始动作空间中逐步选择,而是在宏动作空间中进行决策:

图片

图片

其中,宏动作代表一段连续的动作序列。

最后是智能体训练。在训练过程中,智能体的策略不再直接输出一个动作,而是选择码本中的索引。选定索引后,解码器会将其还原为对应的宏动作,并在环境中执行。

这一过程让智能体的行为始终保持在人类演示的“轨迹流形”中,避免了偏离人类风格的动作。

MAQ的优势非常突出。首先,它显著减少了动作空间的复杂度。原始动作空间往往是连续且庞大的,而宏动作码本则是有限的、结构化的,极大地提升了训练效率。

其次,它保证了智能体的行为始终落在人类演示的轨迹范围内。这意味着智能体的动作不仅能完成任务,还能展现出自然、可信的类人风格。

从整体来看,MAQ框架的设计既有理论上的优雅性,又有实践上的高效性。它通过轨迹优化与动作量化的结合,让强化学习智能体在性能与人类风格之间找到了新的平衡点。这一方法的提出,标志着类人强化学习研究迈出了关键一步。

3.实验设计与评估

为了检验MAQ框架的有效性,研究团队选择了D4RL Adroit基准任务作为实验场景。

这一套任务在强化学习领域广为人知,涵盖了四个具有代表性的机器人操作:开门(Door)、锤击(Hammer)、笔转动(Pen)、以及物体搬移(Relocate)。这些任务不仅动作复杂,而且都提供了人类演示数据,因此非常适合用来评估智能体的“类人性”。

在对比实验中,团队引入了几种主流的强化学习算法作为参照。包括IQL(Implicit Q-Learning),一种结合离线与在线训练的算法;SAC(Soft Actor-Critic),以稳定性和探索能力著称的强化学习方法;以及RLPD(Reinforcement Learning with Policy Distillation),代表了当前离线强化学习的先进水平。除此之外,研究团队还加入了行为克隆(Behavior Cloning, BC)作为基线。

BC直接模仿人类演示,虽然在动作相似度上有一定优势,但在任务完成率上往往表现不佳,因此它是一个很好的对照点。

为了全面衡量智能体的表现,研究团队设计了多维度的评价指标。首先是动态时间规整(DTW),用于衡量智能体轨迹与人类演示轨迹的相似度。DTW能够处理轨迹长度和时间上的差异,捕捉两者在动作顺序上的匹配程度。

其次是Wasserstein距离(WD),它从分布角度衡量智能体与人类演示的差异,反映整体行为模式的接近程度。除了相似度指标,团队还考察了任务成功率,确保智能体在追求类人性的同时不丧失完成任务的能力。

最后,研究团队进行了人类评估实验,类似于图灵测试,让人类参与者直接判断智能体的行为是否像人类,从而获得更直观的验证。

这一套实验设计既有理论上的严谨性,又有实践上的针对性。通过多维度的量化指标与人类直觉的结合,研究团队能够全面评估MAQ框架在“类人性”与“任务性能”之间的平衡。这也为后续的实验结果分析奠定了坚实基础。

4.实验结果与分析

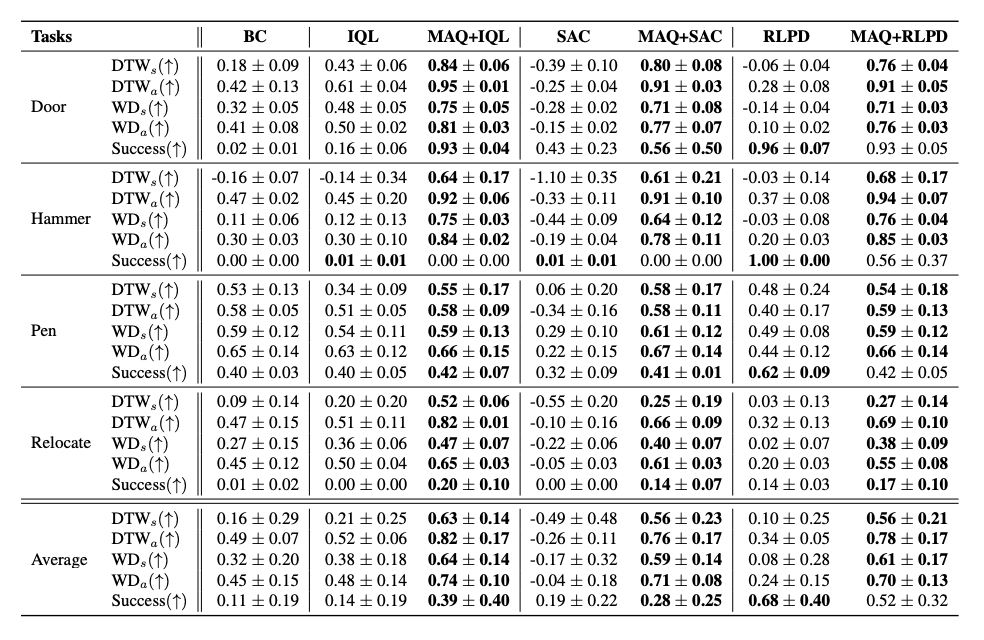

实验结果非常令人振奋。首先,在轨迹相似度方面,MAQ在所有任务中都显著提高了DTW和WD分数。无论是状态序列还是动作序列,MAQ智能体的表现都更接近人类演示。尤其是在SAC算法上,差距最为明显。

传统SAC完全依赖环境交互,缺乏人类演示的约束,因此其行为与人类差距较大。而在引入MAQ后,SAC的轨迹相似度大幅提升,显示出MAQ对纯交互型算法的改造效果尤为显著。

图片

图片

表1:D4RL的Adroit基准测试结果。每种算法的基线与MAQ不一致通常会提高每个控制任务中所有原始算法的相似性得分。

在任务成功率方面,MAQ智能体同样表现出色。在Door和Hammer任务中,MAQ智能体的成功率接近甚至超过了基线算法。这说明MAQ不仅让智能体更像人类,而且没有牺牲任务完成的能力。

图片

图片

图2:MAQ+RLPD中不同长度的轨迹相似性得分和成功率。

相比之下,BC虽然在相似度上有一定优势,但由于它只会机械地模仿演示数据,缺乏优化能力,因此在成功率上表现最差。

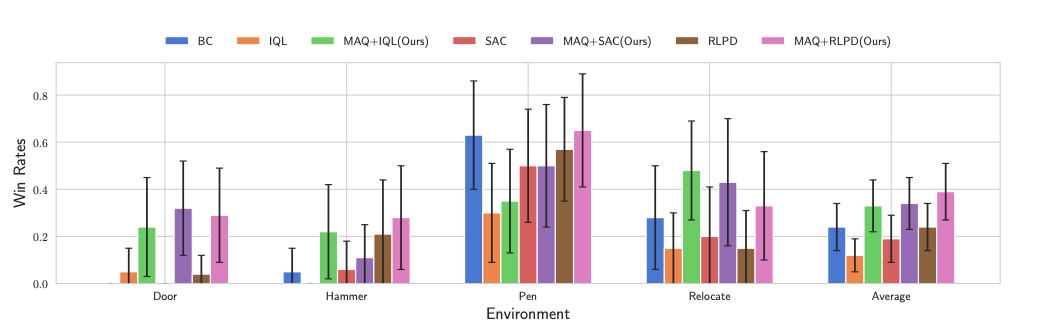

图3:图灵测试。误差条表示96%的置信区间。

图3:图灵测试。误差条表示96%的置信区间。

图3的条形图统计了各类智能体的获胜率,即在评估者眼中,智能体的行为被误认为比人类演示更像人类的比例。

结果与前文的轨迹相似度分析高度一致:引入MAQ的智能体在获胜率上显著超过了没有MAQ的传统RL算法。这说明,通过宏动作量化进行轨迹优化,尤其是采用较长的宏动作片段,能够有效提升智能体的类人性。

最具说服力的是人类评估结果。在实验中,参与者能够轻易识别出传统RL智能体的“非人类”行为,比如不自然的抖动或奇怪的动作模式。

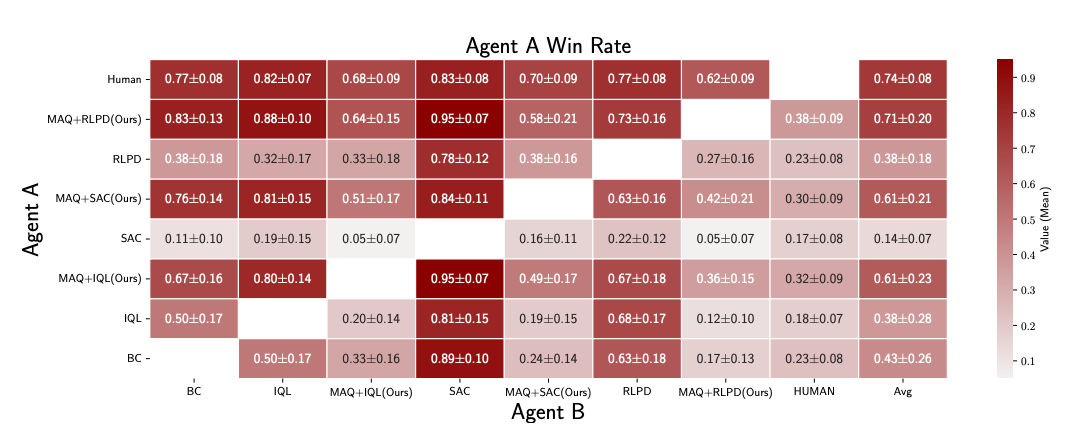

图4:人类相似度排名测试。

图4:人类相似度排名测试。

图4通过热图的形式总结了四个任务的对比结果,每个单元格代表评估者在直接比较两个智能体的视频时,认为纵轴上的智能体比横轴上的智能体更像人类的频率。

整体排名非常清晰:人类(74%) > MAQ+RLPD(71%) > MAQ+SAC(61%) = MAQ+IQL(61%) > BC(43%) > RLPD(38%) = IQL(38%) > SAC(14%)。这一顺序与前面图灵测试的结果高度一致,仅在IQL与SAC的位置上出现了小幅颠倒。这种一致性说明人类评估者的判断是稳定的,他们能够明确区分人类演示与传统RL智能体的行为差异。

更令人瞩目的是,MAQ+RLPD的获胜率达到71%,几乎与人类演示的74%持平。这意味着在直接对比中,MAQ+RLPD已经能够在大多数情况下“欺骗”人类评估者,让他们误以为其行为与人类一样自然。这一结果不仅是数值上的突破,更是感知层面的重大进展:它表明通过宏动作量化与轨迹优化,强化学习智能体可以在行为表现上逼近人类的水平。

当面对MAQ智能体时,参与者往往难以区分其与人类演示的差别。这一结果几乎就是类图灵测试的胜利,证明MAQ在行为层面真正实现了“以假乱真”。

5.研究贡献与意义

这项研究的最大亮点在于方法上的创新。团队提出了宏动作量化(Macro Action Quantization, MAQ)框架,通过条件VQVAE将人类演示转化为可学习的离散动作空间。

相比传统的逐步动作选择,MAQ让智能体在更高层次的“宏动作”空间中进行决策,从而避免了机械、僵硬的行为模式。这种方法不仅优雅地解决了动作空间过于庞大的问题,还确保了智能体的行为始终落在人类演示的轨迹流形之中。

更重要的是,MAQ在性能与人类风格之间找到了平衡点。过去的模仿学习往往在类人性上有所提升,但牺牲了任务成功率;而纯粹的强化学习算法虽然能完成任务,却缺乏自然性。

MAQ的贡献在于,它既保持了任务完成的高成功率,又显著提升了人类相似度。这意味着智能体不再需要在“效率”与“类人性”之间做出取舍,而是能够兼顾两者。

在应用潜力方面,MAQ展现出极大的扩展性。它不仅适用于当前的基准任务,还可以推广到更复杂的场景,尤其是连续动作空间的任务。

随着机器人控制、自动驾驶和虚拟交互的复杂度不断提升,MAQ的宏动作量化策略能够帮助智能体在这些场景中展现更自然、更可信的行为。

未来的研究方向同样令人期待。首先是多模态人类演示的引入,不仅仅是动作数据,还包括视觉信息甚至语言指令,这将让智能体的学习更全面、更贴近真实人类的决策过程。其次是更大规模的轨迹优化,通过更丰富的数据和更强的计算能力,进一步提升智能体的类人性。

最后,在人机交互与机器人控制领域,MAQ的应用前景广阔。无论是服务机器人、医疗辅助,还是虚拟助手,类人风格的智能体都能显著提升用户体验与信任度。

总体而言,MAQ框架为“类人强化学习”开辟了一条新的研究路径。它通过轨迹优化与动作量化的结合,让智能体不仅能够完成任务,还能展现自然、可信的人类风格。这种方法的提出,标志着强化学习研究从单纯追求性能,迈向兼顾人类风格与社会接受度的新阶段。

在未来的AI设计中,可信度与可解释性将成为核心要求。MAQ的研究成果为这一趋势提供了重要启示:智能体的成功不应仅仅以任务完成率衡量,更应考虑其行为是否符合人类的直觉与习惯。通过这种类人化的设计,AI不仅能成为高效的工具,更能成为值得信赖的伙伴。

这篇研究的意义在于,它让我们看到了一个更自然、更人性化的AI未来。MAQ框架的提出,不只是技术上的突破,更是对“类人智能”这一长期目标的有力回应。(END)

参考资料:https://arxiv.org/pdf/2511.15055

文章来自:51CTO