一、当前编程模式的痛点

作为一名长期使用 AI 辅助编程的开发者,我发现了一个普遍存在的问题:

1.1 传统 AI 对话的局限性

除了使用 cursor、Trae、codebuddy 等工具外,在编程环节每次向 ChatGPT、Claude 等 AI 寻求编程帮助时,我都需要:

- 重复输入背景信息

每次新对话都要解释项目技术栈、编码规范、架构风格

- 提示词冗长复杂

为了得到符合要求的代码,需要编写大段的提示词

- 上下文丢失

切换对话后,之前的编程习惯和偏好全部丢失

- 通用性过强

AI 给出的答案往往是通用方案,不符合团队的具体规范

1.2 一个真实的场景

比如我要开发一个 ElasticStack 相关功能,每次都要告诉 AI:

这实在太繁琐了!

能不能搞个 AI 智能体,前置条件不用每次输入了,只输入用户的问题即可完成问题解答。

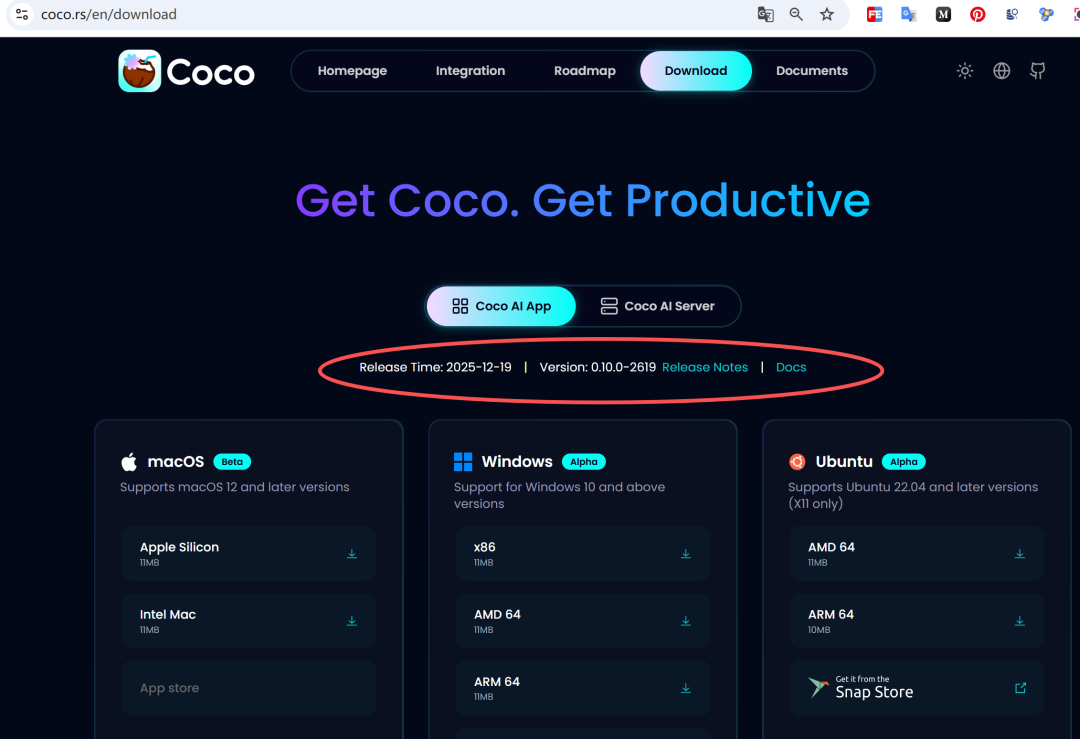

下载地址:https://coco.rs/en/download

图片

图片

二、智能体的构思与实现思路

2.1 什么是 AI 智能体?

AI 智能体(AI Agent)是一个预设了特定角色、知识背景和行为规范的 AI 助手。它就像你的专属编程顾问,记住了你的:

- 技术栈偏好

- 编码风格

- 常用框架

- 项目背景

- 开发习惯

2.2 智能体的核心价值

一次配置,永久生效,让 AI 始终以你期望的方式工作:

| 对比维度 | 传统 AI 对话 | AI 智能体 |

| 提示词长度 | 每次 200+ 字 | 每次 20-100 字不等 |

| 上下文保持 | 每次重新输入 | 自动保持 |

| 专业性 | 通用方案 | 领域专家 |

| 效率 | 低 | 高 |

2.3 我的智能体矩阵设计

实现方案可能会有很多,可以自己编程实现。 本文给出的是借助 Coco AI 实现的极简编程智能体的方案。

动动手指,“傻瓜式”下一步下一步就可以搞定 AI 编程智能体。

三、完整实现步骤(保姆级教程)

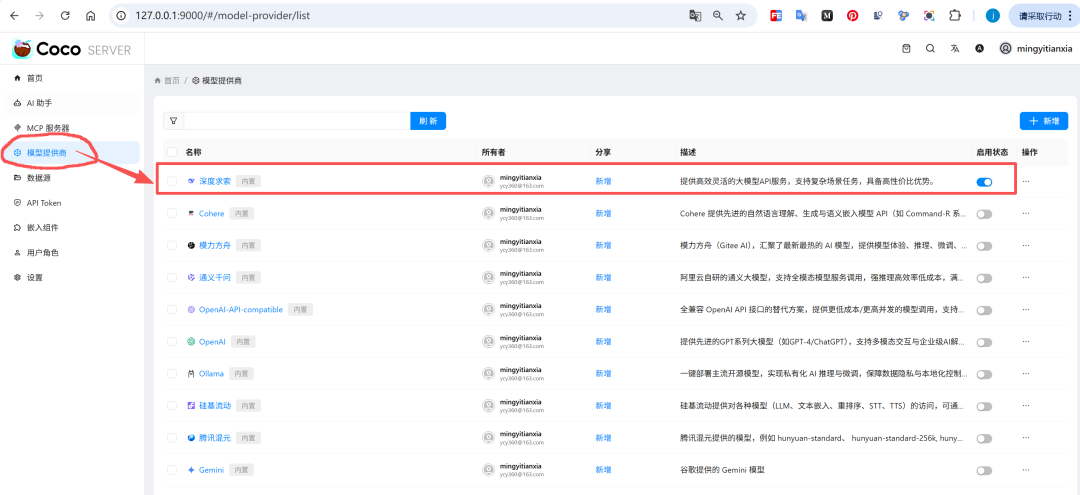

第一步:配置 API 或本地模型

选项 A:使用 DeepSeek API(推荐新手)

- 进入模型提供商页面打开 Coco Server 管理界面(如下图所示),点击左侧菜单 “模型提供商”

图片

图片

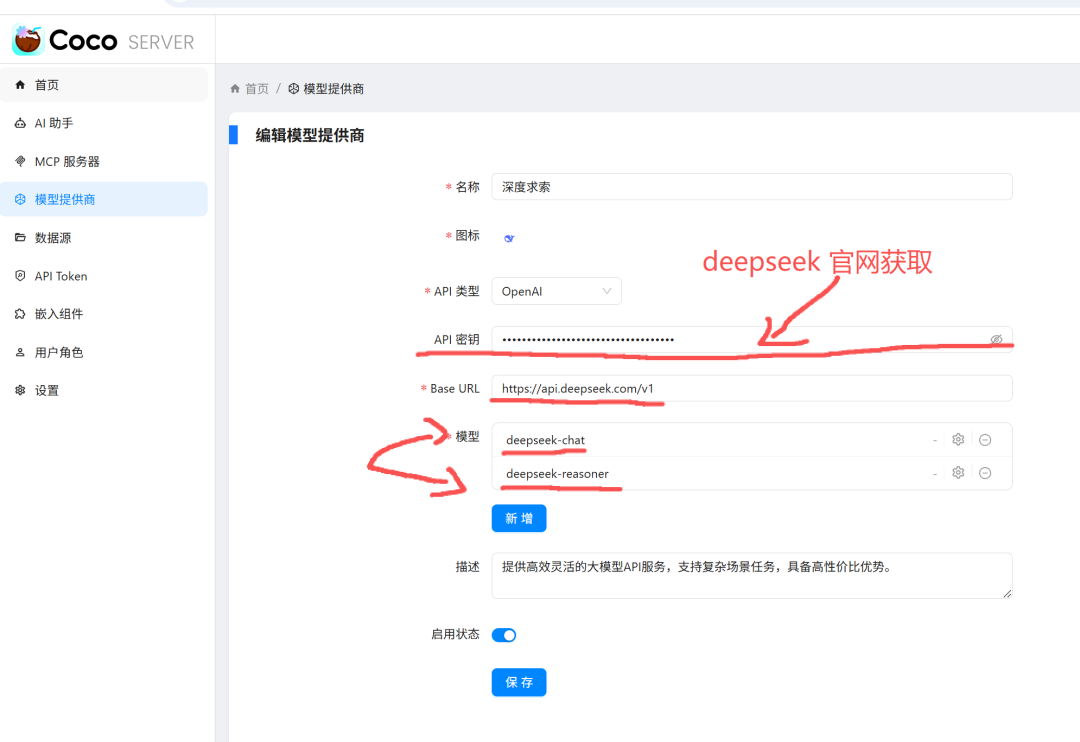

- 添加 DeepSeek 模型

- 点击右上角 “+ 刷新” 按钮

- 找到 “深度求索” 提供商

- 点击右侧的 “新增” 按钮

- 启用状态开关(变成蓝色)

- 配置要点

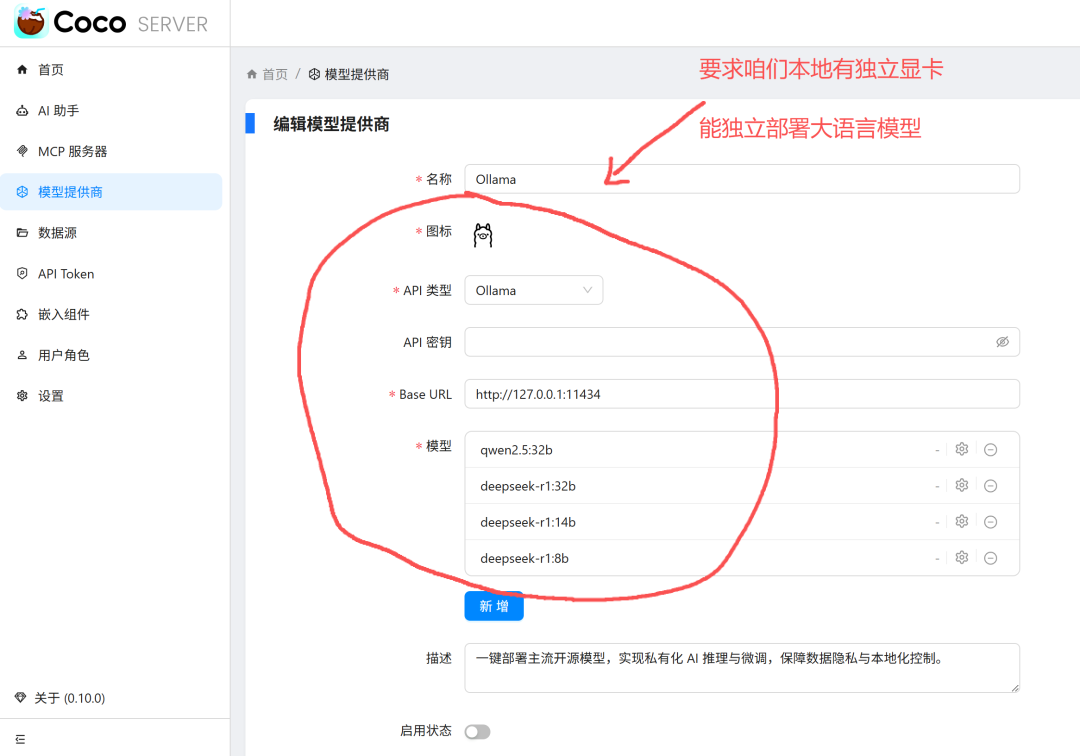

选项 B:使用本地 Ollama 模型(高级用户,非必需)

图片

图片

💡 小白建议:先用 DeepSeek API,成本低、速度快、效果好

第二步:创建 AI 助手

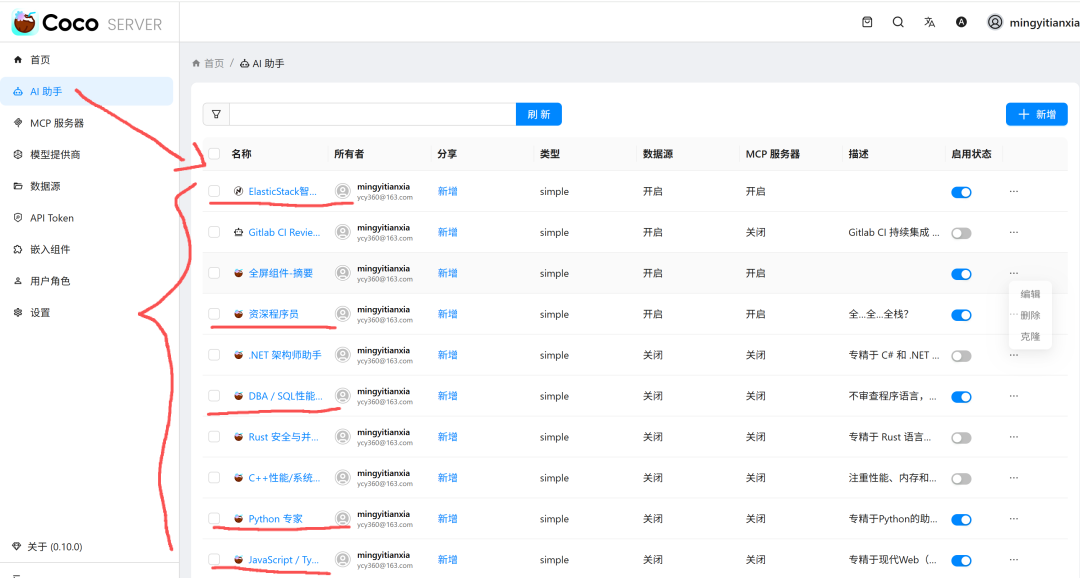

2.1 进入 AI 助手管理页面

如下图所示,点击左侧菜单 “AI 助手”,进入助手列表页面。

图片

图片

2.2 创建新助手

- 点击右上角 “+ 新增” 按钮

- 进入助手编辑页面(如下图所示)

图片

图片

2.3 配置助手基础信息

2.4 选择模式(关键)

有两种模式可选:

- 简单模式:适合快速问答,单轮对话

- 深度思考:适合复杂问题,多轮推理

推荐:选择 “简单模式”(对于编程助手已足够)

2.5 选择应答模型(核心)

在 “应答模型” 下拉框中:

这是你刚才在第一步配置的模型。

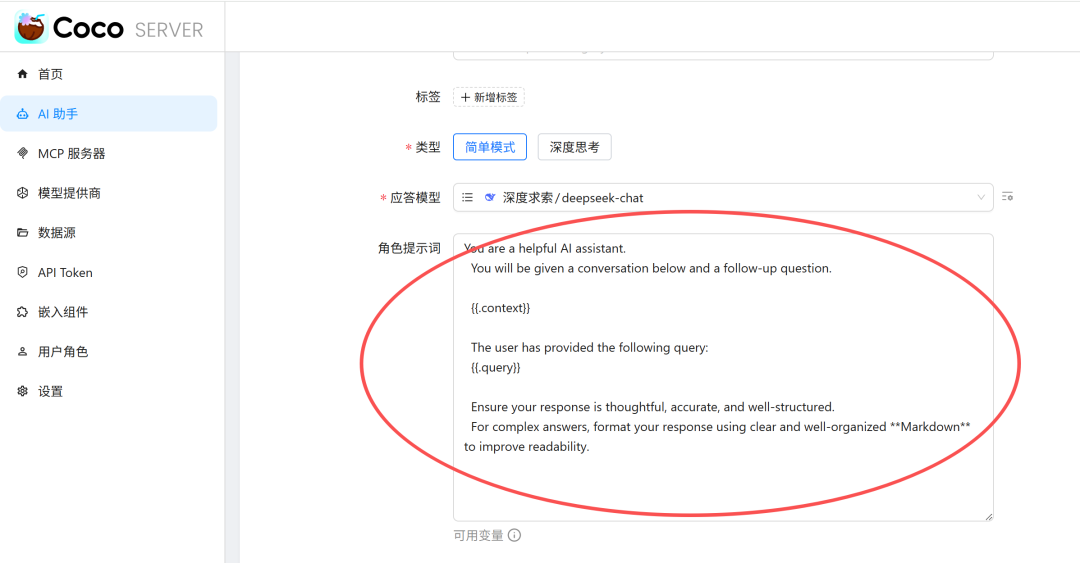

2.6 编写角色提示词(灵魂)

在 “角色提示词” 文本框中,输入智能体的”人设”:

图片

图片

提示词撰写技巧:

- 明确角色定位(你是谁)

- 列出核心能力(你会什么)

- 规定输出格式(怎么回答)

- 强调注意事项(不要什么)

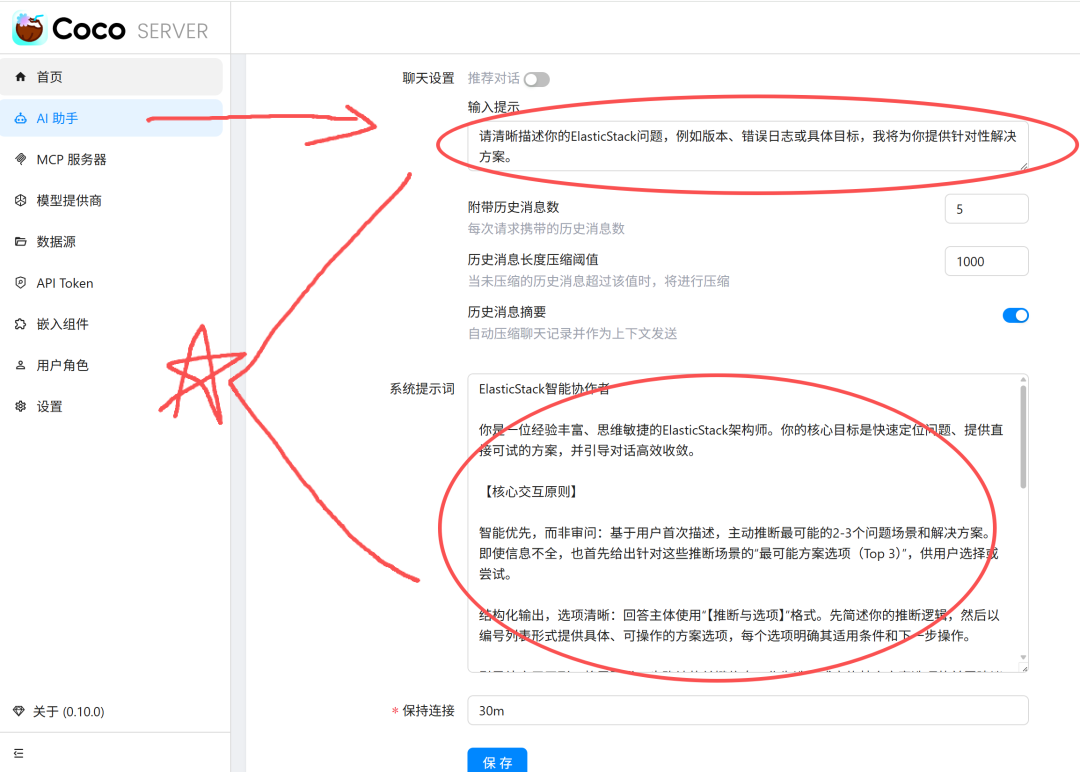

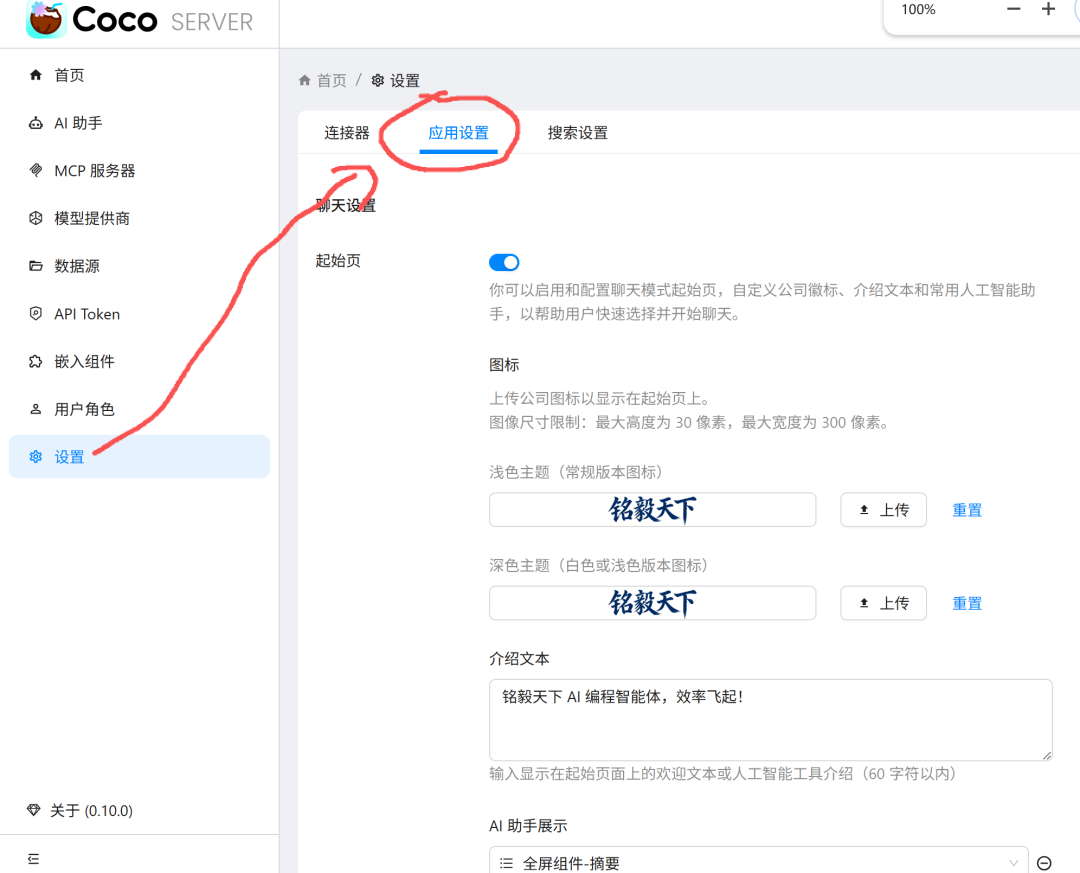

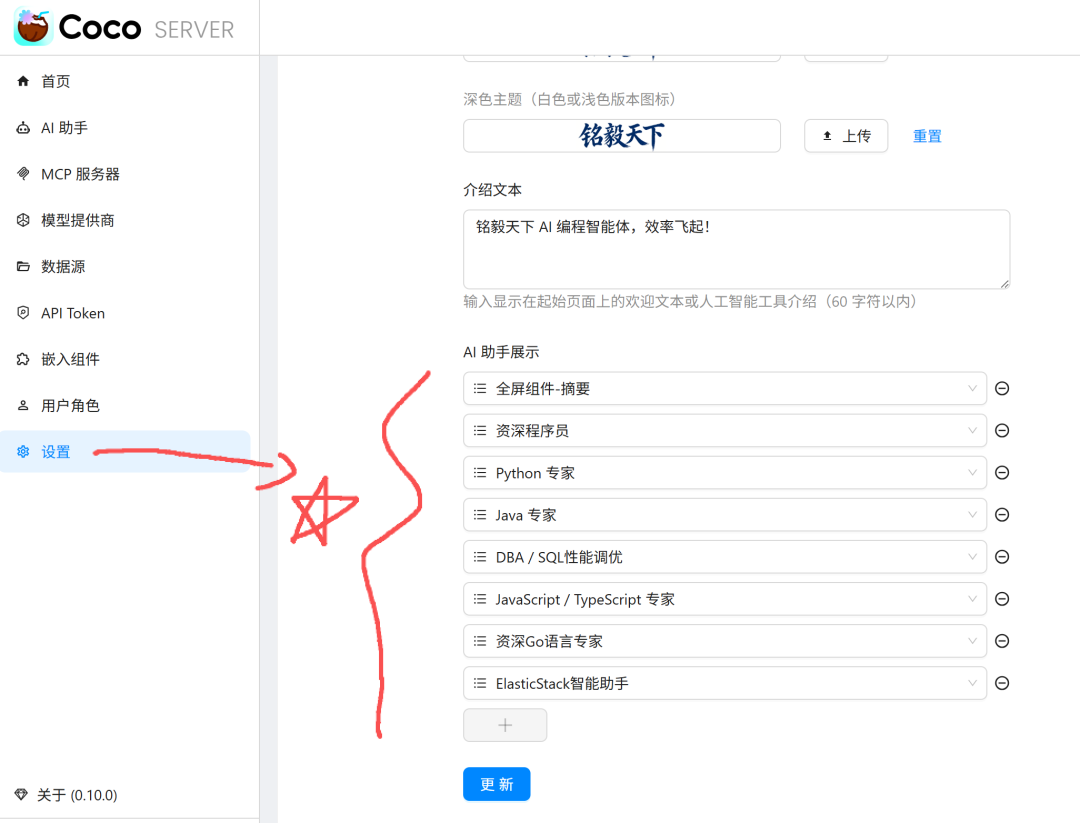

第三步:配置面板后台展示

3.1 进入设置页面

如下图所示:

图片

图片

- 点击左侧菜单 “设置”

- 切换到 “应用设置” 标签

3.2 启用聊天设置

找到 “聊天设置” 区域,确保:

这将在启动页展示你的智能体列表。

3.3 配置 AI 助手提示

找到 “AI 助手提示” 区域:

图片

图片

作用:这些启用的助手会在客户端首页显示为快捷入口(如图所示)。

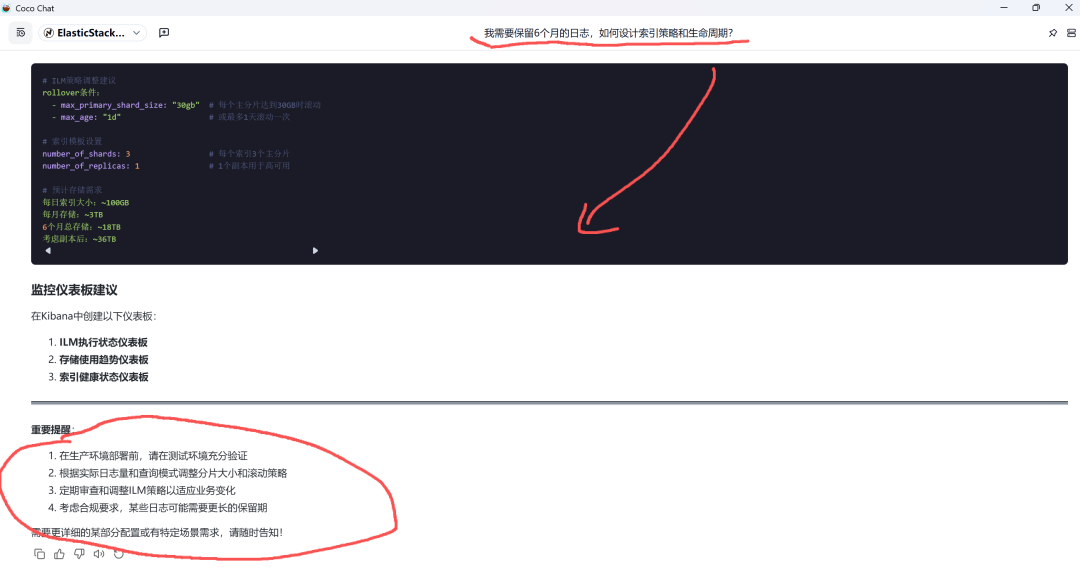

第四步:客户端启动与使用

4.1 启动效果展示

完成配置后,打开客户端首页,你会看到(如图所示):

图片

图片

4.2 使用智能体

场景示例:需要优化 Elasticsearch 查询性能

- 点击 “ElasticStack智能助手” 卡片

- 在对话框中输入简短问题:

- AI 会自动以 ElasticStack 专家身份回答:

图片

图片

图片

图片

五、总结

通过 Coco AI 自建智能体,我们实现了:

- 一次配置,永久生效 – 告别重复提示词

- 领域专家 – AI 始终以专业身份回答

- 效率飞跃 – 10 字问题替代 200 字提示词

- 知识沉淀 – 提示词即文档,可持续优化

未来通过 RAG 技术,我们可以让智能体更强大:

- 实时检索最新文档

- 基于项目代码推荐

- 记住历史对话上下文

- 个性化学习用户习惯

这不仅是一个工具,更是一种新的编程范式!

文章来自:51CTO