过去两年里,企业面临的最大变化,不是“AI能做什么”,而是AI正在以“不可见”的方式进入你的数据通道:员工自带工具(BYOAI)、SaaS内嵌AI助手默认启用、OAuth/插件一键授权、以及以MCP为代表的“Agent连接协议”把模型直接接到企业系统后端。

微软与LinkedIn在《Work Trend Index》中指出,78%的AI用户会把自带AI工具带到工作中,这意味着大量AI使用天然绕开审批与审计。 另一方面,Netskope《Cloud and Threat Report: 2026》给出更“安全视角”的事实:影子AI(个人/非托管账号)仍占生成式AI用户的47%,平均组织每月可见约223起向AI应用发送敏感数据的违规事件。

因此,AI应用爆发式增长带来了一个严峻挑战:如何发现和管理员工在未经审批的情况下使用的”影子AI”工具?

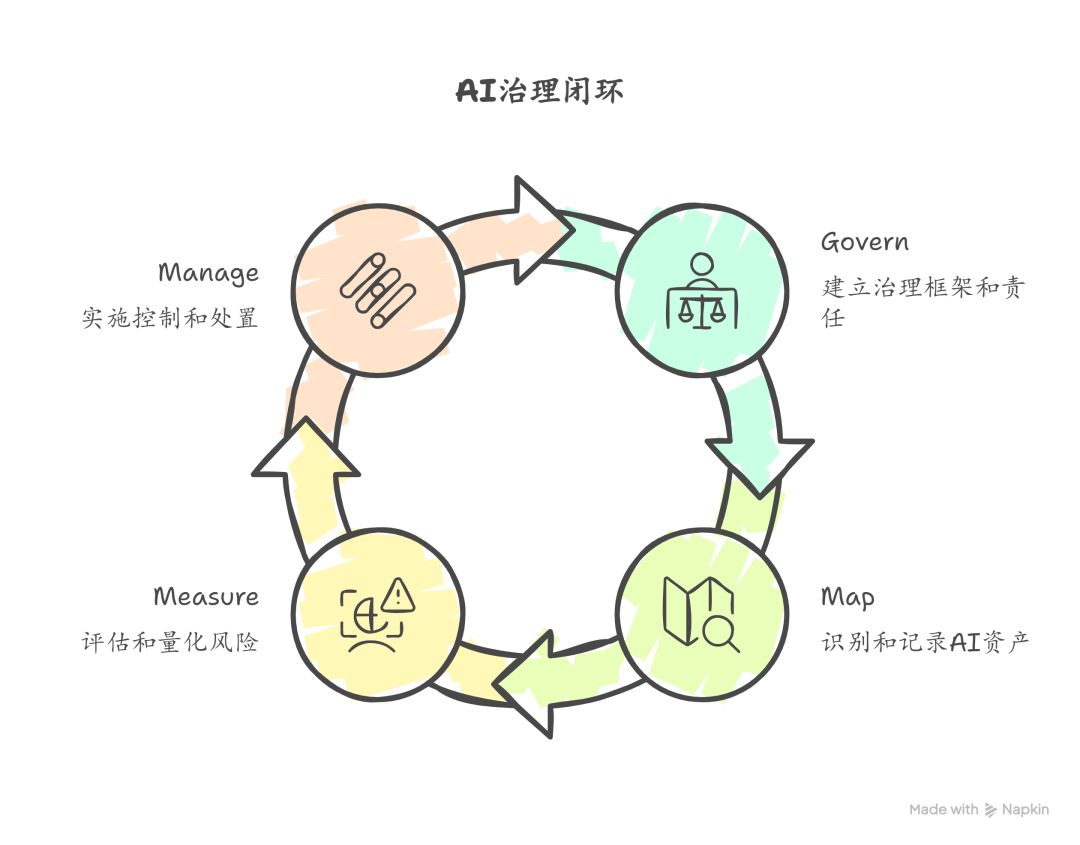

先给结论:影子AI治理的“三步走”

- 第一步:发现(Map)——建立“AI资产清单”,覆盖应用、账号、集成、嵌入式AI、MCP/Agent连接与用户活动。

- 第二步:分级(Measure)——用统一的风险评分把“该封/该纳管/该引导/该放行”说清楚。

- 第三步:管控(Manage + Govern)——把处置动作固化为流程(撤权、阻断、准入、替代方案、培训与复盘),形成闭环。

以下通过10个方面来说明如何在发现影子AI的基础上实施有效的AI治理。

1.什么是影子AI?

影子AI指的是员工在没有经过IT部门正式审批流程的情况下,自行试用和采用的AI应用及功能。这些工具可能包括豆包、通义、元宝等聊天机器人,也包括嵌入在现有SaaS工具中的AI功能。

与传统的网络资产发现不同,AI资产清单需要捕获的是第三方AI应用、用户账户、跨应用集成、模型上下文协议(MCP)连接,以及AI供应链依赖关系等信息。

2.为什么说“影子AI正在吞噬数据边界”?

你过去构建的数据边界,核心靠三件事:账号可控(SSO/企业账号)、权限可控(最小权限)、审计可追溯(日志与留痕)。影子AI恰好从三个方向同时瓦解它:

- 员工自带AI工具,把“数据外发”变成日常动作

78%的AI用户自带工具(BYOAI)意味着:即使你部署了企业版AI,仍有大量人会“企业版+个人版混用”,形成审计盲区。

- SaaS内嵌AI,让“AI访问数据”变成默认能力

过去你能靠“禁止安装某工具”来管住风险;现在大量风险来自SaaS自身的AI功能:它可能读取邮件、文档、工单、代码库、知识库,并将内容发送给底层模型或第三方服务。你如果仍用“工具黑名单”思路,会发现永远跟不上变化。

- MCP/Agent连接让“对话式使用”升级为“系统级调用”

MCP这类协议的核心不是“又一个插件”,而是把企业系统能力抽象为模型可调用的工具接口:模型可以通过后端API查询、创建、修改业务对象。 微软等厂商也在把MCP视作连接企业系统与Agent的重要基础设施,这意味着它会迅速进入企业真实环境。

对安全团队而言,这类连接的风险形态更像“新一代集成风险”:Token/凭据滥用、权限继承导致横向扩权、提示注入诱导越权调用、审计链断裂等。

3.为什么AI发现如此重要?

有效的AI发现能帮助企业回答以下关键问题:

- 组织中有哪些人在使用AI工具?

- 是否有未经批准的AI工具绕过了治理流程?

- AI工具与哪些存储关键业务数据的应用集成,访问权限有多大?

- 其他工作场所技术解决方案中的AI功能是否使数据可被大语言模型访问?

- SaaS供应商的供应链中是否使用了AI,他们提供了哪些数据隐私保证?

Netskope基于匿名化企业数据的统计显示,影子AI仍然普遍存在(47%为个人AI应用/账号路径),并伴随每月平均223起向AI应用发送敏感数据的违规事件。

4.AI发现应该包括哪些内容?

- 专用AI应用

这类应用如Deepseek、Qwen、ChatGPT、Perplexity、Claude等,为员工提供与大语言模型交互的用户界面。理想情况下,你需要发现所有这类应用的全部用户账户。

关键提示: 寻找能够通过模式匹配识别AI工具的解决方案,而不是依赖静态列表。任何固定的AI工具清单都会很快过时。

- 授予AI工具数据访问权限的集成

许多AI工具通过OAuth授权或原生市场应用与其他平台轻松连接。员工可能无意中授予AI工具访问整个企业网盘、日历或电子邮件的权限。

一个典型例子是AI会议记录应用,它们会提示用户授予日历和联系人访问权限,并默认”加入每个会议”。突然间,未经批准的AI记录工具出现在讨论敏感话题的会议中。

关键提示: 寻找能够提供详细的应用间集成清单的解决方案,包括OAuth授权、API等方法的详细信息,最好能够直接撤销有风险的访问权限。

- 嵌入式AI的SaaS应用

这个经常被忽视但增长最快的类别是在产品内嵌入AI功能的SaaS应用。启用这些嵌入式AI功能可能导致底层大语言模型获得超出预期的数据访问权限。

关键提示: 某些SaaS和AI安全解决方案可以展示和总结供应商的数据训练政策,包括数据是否用于模型训练、可用的退出选项、保留期限等信息。

- MCP服务器集成

随着Anthropic发布开源模型上下文协议(MCP),企业数据被AI工具访问的方式发生了重大转变。主要SaaS提供商纷纷跟进,宣布自己的MCP服务器和原生AI集成。

MCP服务器允许大语言模型通过后端API直接查询SaaS应用,从而大幅扩展数据访问范围。这些连接通常授予AI工具与创建连接的用户相同的数据权限,可能导致更广泛的数据访问。

关键提示: SaaS安全态势管理(SSPM)工具在这方面很有帮助,它们通常会清点已连接应用中启用的集成。

- 其他SaaS提供商供应链中的AI

另一个经常被忽视的类别是其他SaaS应用提供商供应链中的AI。例如,某些公司使用AI工具来优化客户支持运营。如果在支持案例中分享了敏感数据,这些数据现在可能被底层大语言模型访问。

- AI用户活动

最后,需要考虑用户可能通过聊天提示或文件上传与AI工具共享的数据。检测这些活动通常需要基于浏览器、终端或网络的控制措施。

5.AI发现的主要方法

- 方法一: 基于网络的监控和终端代理

这种方法通过安装在设备上的桌面代理或通过防火墙、VPN的网络级监控来捕获用户流量。

优点: 监控云服务访问、应用安全策略

缺点: 仅限于企业网络、对远程工作支持有限、资源密集、需要终端代理、无历史发现能力

- 方法二: 基于浏览器的发现

通过部署到企业设备的轻量级浏览器扩展直接监控应用使用情况。扩展可以检测AI网站访问、账户注册、登录活动、文件共享、提示内容等。

优点: 精细的用户活动数据、实时干预、使用模式洞察

缺点: 遗漏移动/个人设备使用、历史数据有限、依赖安装、域支持可能有限

- 方法三: 基于电子邮件的发现

分析来自SaaS和AI提供商的企业电子邮件通信,寻找AI活动的证据——如欢迎邮件、密码重置、账单通知、多因素认证提示等。

优点: 广泛的发现覆盖、发现未知应用、历史洞察、检测各种账户类型

缺点: 对个人账户的可见性有限、实际能力因供应商而异

- 方法四: 与SaaS应用的API连接

SSPM解决方案通过与特定SaaS应用的直接API连接工作,可以提供应用间集成和应用配置的详细可见性。

优点: 可见AI工具与关键应用之间的集成、支持审查数据共享权限、持续安全监控

缺点: 仅限于已知应用、API可用性因供应商而异、部署工作量较大、应用覆盖有限

6.理想的AI发现解决方案

由于每种发现方法都有其优势和局限性,最理想的解决方案应该采用分层方法,结合多种发现技术:

- 全面覆盖: 结合电子邮件分析、API集成、SSO连接和浏览器扩展,提供最广泛的AI使用可见性

- 自动发现: 在引入新AI应用和集成时持续识别,需要最少的设置或维护

- 历史洞察: 发现过去创建的AI账户,即使是在开始使用解决方案之前引入的应用

- 丰富的上下文: 提供使用模式、用户角色、身份验证方法和安全配置的详细信息

- 可扩展性: 不需要复杂的基础设施、终端代理或网络监控工具,适合现代分布式工作场所

“理想方案”不等于“大而全采购”。很多企业可以从“邮件线索 + SSO/IdP日志 + OAuth授权清单 + 浏览器侧行为可见性”四件事组合起步,先把高风险面看清,再逐步加深能力。

7.发现之后先别急着封——先做风险分级

影子AI治理常见失败点是“一刀切封禁”,结果是:业务转向更隐蔽的个人账号与绕行路径,风险更不可见。更优做法是风险分级→差异化处置。

风险分级四维模型

给每个AI资产(应用/集成/嵌入式AI/MCP连接)打分:

- 数据敏感度:是否涉及个人信息、财务、人事、客户合同、源代码、凭据/API Key等。

- 权限范围:是否“全盘读取/批量导出/可写可改/可创建业务对象”。

- 账号可控性:企业账号+SSO+审计 vs 个人账号/不可导日志。

- 外部处理与保留:数据是否可能用于训练、保留多久、是否可选择退出(以供应商承诺与配置为准)。

三档处置策略

- 高风险(立即止血):个人账号 + 访问核心数据源/大范围OAuth scope/MCP直连关键系统 → 立即撤销授权、阻断访问、提供企业替代方案、同步复盘通报。

- 中风险(纳管与加固):企业账号但权限偏大/嵌入式AI默认开启且可见性不足 → 收紧权限、开启审计、配置DLP/敏感标签策略、建立审批白名单。

- 低风险(可放行但要留痕):只处理公开或低敏信息、权限最小、可审计 → 允许使用,但纳入台账与周期复核。

8.AI治理闭环

NIST AI RMF把AI风险管理拆为四个功能:Govern / Map / Measure / Manage。

Govern(治理与责任)

- 明确RACI:业务Owner、IT、Sec、数据合规/法务、采购、HR分别对“引入—使用—审计”承担什么责任。

- 把影子AI纳入制度:AI使用政策、第三方集成准入、数据分级与外发规则、违规处置机制。

- 若组织希望体系化,可参考ISO/IEC 42001:2023作为“AI管理体系”的框架化抓手(管理系统标准)。

Map(发现与建账)

- 建“AI资产清单”与“影子AI暴露面地图”,至少月度更新;

- 覆盖六类资产 + 四类信号源

Measure(分级与度量)

- 使用四维模型打分;

- 输出Top风险清单、趋势图、处置MTTR,并形成可审计证据链。

Manage(控制与处置)

- 处置动作库:撤权、阻断、迁移到企业版、最小权限、开启审计、敏感标签+DLP、教育与复训;

- 复盘机制:每月复盘“新增影子AI来源、绕行方式、制度漏洞、配置缺陷”。

9.实施建议

针对影子AI,以下提出30天、60天、90天的“速赢”方案供参考:

30天:先“看见”高风险面

- 建最小台账(应用/账号/集成/MCP连接/负责人/数据源/权限范围);

- 先抓三类“高收益信号”:邮箱线索(注册/授权通知)、SSO/IdP登录、OAuth授权清单;

- 产出Top 20影子AI清单 + Top 10高风险集成(可直接给管理层看)。

60天:做风险分级与止血

- 用四维模型分级,定义“高风险即刻处置”门槛;

- 对高风险项执行:撤销OAuth/禁用个人账号入口/提供企业替代;

- 对嵌入式AI:梳理开关与默认策略,统一配置审计与DLP。

90天:形成可持续治理闭环

- 影子AI纳入例行巡检与内审(每月新增、变更、处置、趋势);

- 建“第三方AI/集成准入模板”(训练/保留/退出/地域/子处理者/审计);

- 将NIST AI RMF的Govern/Map/Measure/Manage写入制度与流程,形成长期机制。

10.关键评估问题

在选择AI发现解决方案时,应向明确以下关键问题:

- 使用什么AI发现方法?

- 发现方法是仅面向未来还是可以发现部署前创建的AI资产?

- 能检测哪些资产(AI应用、用户账户、OAuth集成、API集成等)?

- 可以提供哪些关于已发现AI工具的洞察(安全程序详情、数据训练政策、违规历史等)?

- 能否发现AI工具与其他业务工具之间的集成?包括MCP服务器集成?

- 发现之后能否一键撤权/批量处置?能否形成可审计的处置证据?

- 能否区分企业账号 vs 个人账号并对个人账号路径给出治理手段?(否则影子AI永远在)

- 对MCP/Agent连接,能否给出连接注册、权限范围、调用日志、Token生命周期的可见性?

随着AI能力持续嵌入各类SaaS、以及MCP/Agent连接把模型接入企业系统,”AI工具”与”SaaS工具”的界限会继续模糊。企业真正需要的不是更长的黑名单,而是:可见性(发现)—可决策(分级)—可执行(处置)—可持续(治理闭环)。当你能把“不可见的AI使用”变成“可控的业务通道”,AI才会从风险源变成生产力。

文章来自:51CTO