跳至内容

大脑是如何近似反向传播算法的?发表在《自然 – 神经科学》的一篇论文,研究者找到了可以生活在活体大脑并进行实时工作的等价物,他们提出的大脑学习算法模型可以模拟反向传播过程。

每当人类或机器学习更好地完成一项任务时,总会留下一系列的物理变化,比如人类大脑中的细胞或机器学习算法中的数值会发生相应的变化,这些变化是提高其性能的基础。但是,大脑或机器等系统如何准确地计算出需要做出哪些改变并不简单,在这个问题中,大脑或人工智能系统必须查明其 pipeline 中错误的原因,然后做出必要的改变,这一过程可称之为信用分配问题。

更简单地说:这好比一场推卸责任的游戏,需要找出哪部分出错了。

在机器学习(ML)领域,AI 工程师使用「反向传播」这种强大算法解决了机器的信用分配问题,该算法在 1986 年随着 Geoffrey Hinton、David Rumelhart 和 Ronald Williams 的工作而普及。现在,反向传播算法在最成功的 AI 系统(深度神经网络)中为网络学习提供了主要的学习动力。

现在看来,机器学习可以采用反向传播解决信用分配问题,那么大脑中有没有等价的机制解决信用分配问题呢?

今年 5 月发表在《自然 – 神经科学》上的一篇论文《Burst-dependent synaptic plasticity can coordinate learning in hierarchical circuits》中,研究者们终于找到了可以生活在活体大脑中并进行实时工作的等价物。

https://www.nature.com/articles/s41593-021-00857-x

这篇论文由来自加拿大渥太华大学的 Richard Naud 以及麦吉尔大学的 Blake Richards 等研究者参与撰写,他们揭示了一种新的大脑学习算法模型,该模型可以模拟反向传播过程。

麦吉尔大学的 Blake Richards(左)和渥太华大学的 Richard Naud(右),他们提出了一个新的大脑学习模式,最终可以解决人类大脑的信用分配问题。

Naud 表示:「这篇论文的主要目标是表明机器正在进行的学习方式可以通过生理过程来逼近。」

来自柏林洪堡大学的实验神经科学家 Matthew Larkum 表示:「来自更理论化方面的想法可以推动比较困难的实验得以进行,在我看来,这篇论文超越了这一标准,这在生物学上是合理的,可能会带来很大的影响。」

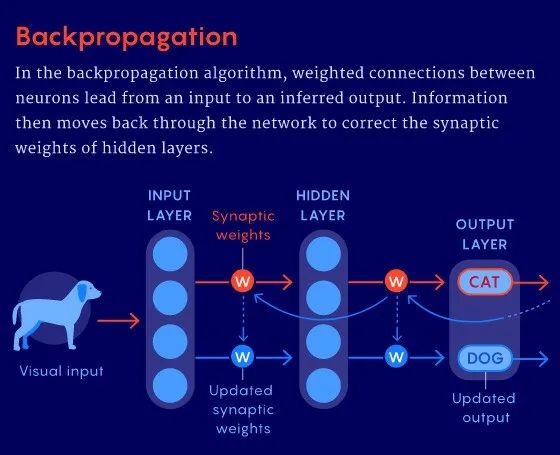

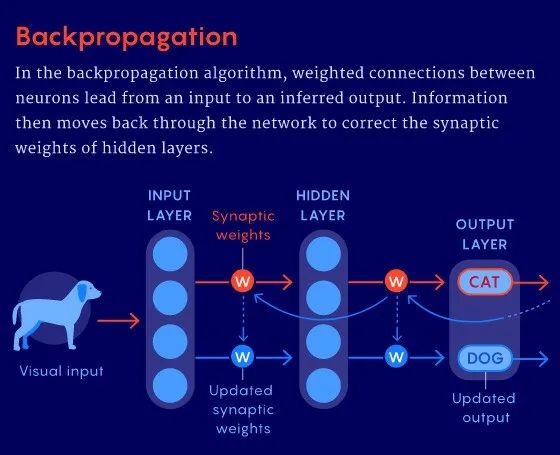

然而,人类和机器实现信用分配问题的过程并不完全相同。对于机器来说,当训练一个识别图像的深度神经网络时,它会分成两个阶段进行:首先是前向传播,然后是反向传播,期间网络会进行「学习」这一过程。在第一阶段,输入层中的神经元编码图像的特征并将其传递,然后隐藏层中的神经元执行计算并将它们的结果传递到输出层,输出层对输出图像进行预测。比如输入一张狗的图像,模型预测出来是一张猫,这时反向传播算法通过调整连接神经元的权重来解决问题,使得模型预测结果是一只狗。

几十年来,研究人员一直试图弄清楚大脑是如何执行类似反向传播操作来解决信用分配问题的。反向传播本身在生物学上是不合理的,因为真正的神经元不可能停止处理来自外部的信息,以等待反向传播。如果大脑是这样工作的,那我们的视觉、听觉或其他感官就会丧失。

Naud 和 Richards 的新模型可以解决这个问题,他们通过对神经元之间进行相互交流的传统理解做了一个简单的改变来实现。我们知道神经元就像比特一样,只有两个输出,要么向另一个神经元发送电活动的尖峰信号(spike of electrical),要么不发送,即 1 或 0。但神经元也可以快速连续地发送「突发(burst)」尖峰信号。事实证明,这种方式可以改变神经元之间的连接,并使「突发」成为解决信用分配问题的一种选择。

在新模型中,该团队认为神经元会突发第三个输出信号,即神经元不停地发送「突发」信号 1,这些信号相隔很近,实际上信号就变成了 2。2 不是对外部信息进行编码的,而是充当「教学信号」,告诉其他神经元根据电路顶部产生的误差,是加强还是削弱它们之间的连接。

但要想让这个教学信号在不「暂停」感官处理的情况下解决信用分配问题,研究者的模型还需要另一个关键部分。他们提出,神经元的顶部和底部有不同的间隔空间,它们以完全不同的方式处理神经代码。「我们的模型表明你真的可以有两个信号,一个上升信号和一个下降信号,它们可以相互传递,」Naud 说。

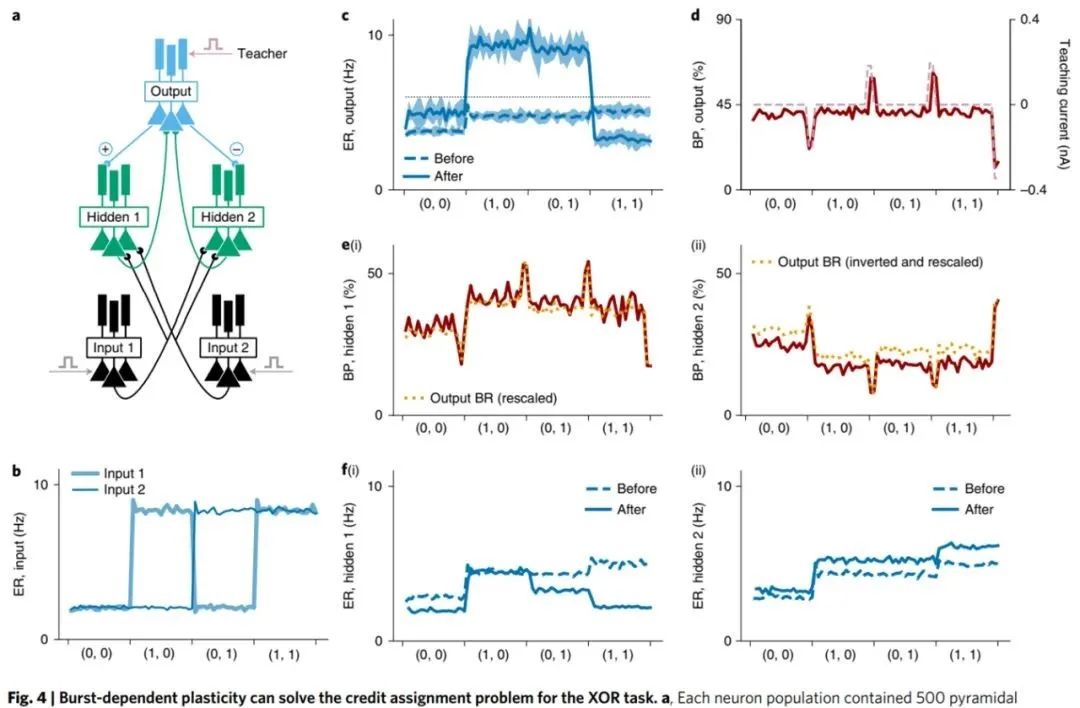

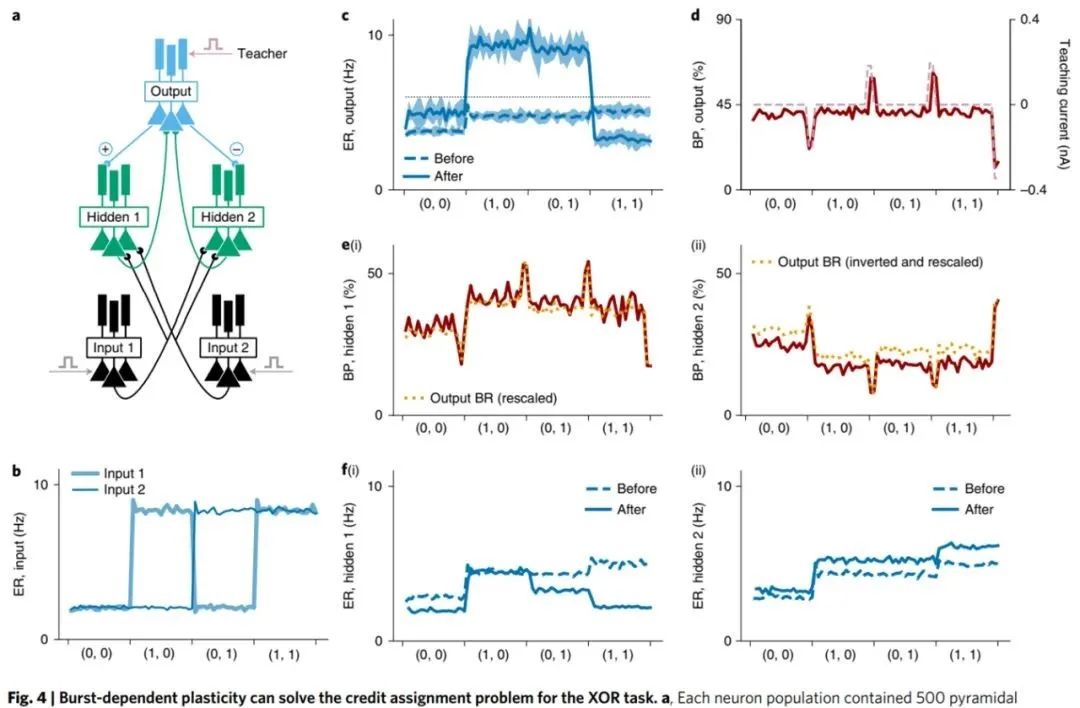

突发相关的可塑性可以解决异或(XOR)任务中的信用分配问题。

研究者假设,在神经元顶端接收输入信号的树状分支只监听突发信号——内部教学信号,以调整神经元之间的连接并减少误差。调整自上而下进行,就像在反向传播中一样,因为在他们的模型中,顶部的神经元正在调节其下方神经元发送突发信号的可能性。

研究者表示,当网络有更多的突发时,神经元往往会增加其连接的强度,而当突发信号不那么频繁时,连接的强度往往会降低。这个思路是这样的,突发信号告诉神经元它们应该在任务期间处于活跃状态,以加强它们之间的连接,这样做可以减少误差,而如果没有突发信号,则告诉神经元它们应该处于非活动状态并且可能需要削弱它们之间的连接。

周期性和反馈连接的突发依赖可塑性通过线性化和调整反馈来促进基于梯度的学习。

与此同时,神经元底部的分支将突发信号视为单个尖峰信号,即正常的外部信号,这使得信号能够继续在回路中向上发送感官信息而不受干扰。

「现在回想起来,这个想法似乎是合乎逻辑的,」苏黎世大学和苏黎世联邦理工学院的计算神经学家 João Sacramento 表示。

过去,其他研究者也试图采用类似的逻辑。20 年前,来自宾夕法尼亚大学的 Konrad Kording 以及奥斯纳布吕克大学 Peter König 提出了一个双室(two-compartment)神经元学习架构。但是该提案缺乏与生物学相关的许多具体细节,而且这只是一个提案,他们无法证明这个双室神经元学习架构是否能真正的解决信用分配问题。

Kording 表示,当时他们只是缺乏测试这些想法的能力。他认为 Richard Naud 以及 Blake Richards 等人的研究是很了不起的工作。

如今借助算力,Naud、Richards 和他们的合作者成功地模拟了他们的模型,其中突发神经元(bursting neurons)扮演了学习规则的角色。他们表明,突发神经元解决了 XOR 经典任务中的信用分配问题,该任务需要学习在两个输入之一为 1 时做出响应。此外,研究结果还表明,使用他们的突发规则构建的深度神经网络可以近似反向传播算法在具有挑战性的图像分类任务上的性能, 不过该研究仍有改进的余地。

这对于 AI 研究人员来说也很兴奋,因为弄清楚大脑如何近似反向传播,反过来又可以改善 AI 系统的学习方式。「如果我们能够深入理解这个过程,那么这最终可能会导致系统能够像大脑一样高效地解决计算问题,」来自荷兰拉德堡德大学 Donders 研究所人工智能系主任 Marcel van Gerven 表示。

内容来源:机器之心

![]()

![]()