本文经AIGC Studio公众号授权转载,转载请联系出处。

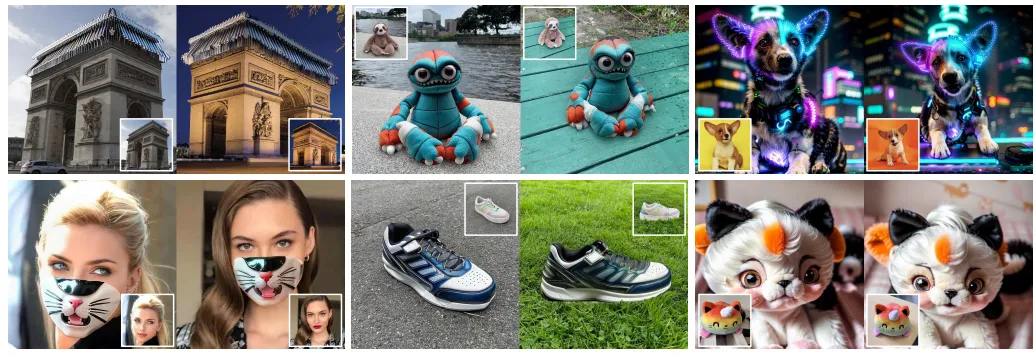

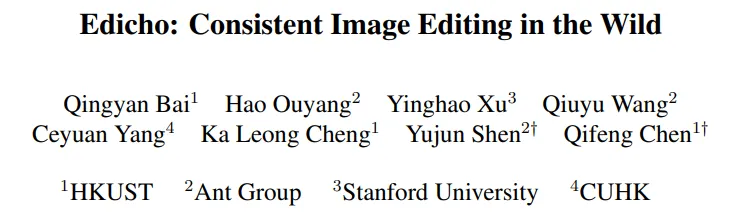

在图像处理领域,如何实现跨图像的一致编辑一直是技术挑战。传统方法往往局限于单张图像的编辑,难以保证多张图像间编辑效果的一致性。香港科技大学、蚂蚁集团、斯坦福大学和香港中文大学联合提出Edicho,这一难题迎来了全新的解决方案。 总结如下:

- 无训练编辑方法:

- 核心创新:Edicho作为一种无训练的图像编辑方法,无需复杂的模型训练过程,即可实现高效、一致的图像编辑。

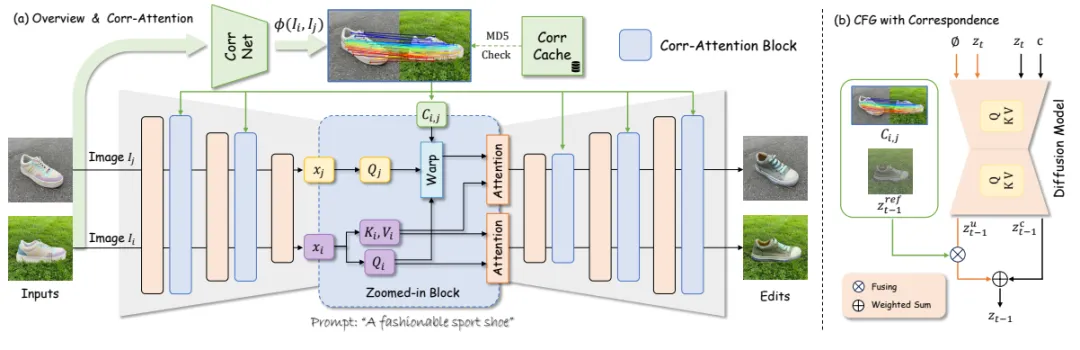

- 技术原理:该方法基于扩散模型,通过显式对应关系来指导编辑过程,确保编辑效果在不同图像间的一致性。

- 显式对应关系:

-

关键组件:Edicho包括一个注意力操纵模块和一个精细调整的分类器无关指导(CFG)去噪策略,两者都考虑了预估对应关系。

-

优势所在:通过显式对应关系,Edicho能够更准确地捕捉和转移图像间的特征,从而实现更自然、更一致的编辑效果。

-

广泛适用性:

-

兼容性强:Edicho具有即插即用的特性,兼容大多数基于扩散的编辑方法,如ControlNet和BrushNet。

-

应用场景:该方法可广泛应用于个性化内容生成、跨视角纹理应用等实用场景,为内容创作者提供了更多可能性。

Edicho的提出不仅解决了跨图像一致编辑的技术难题,还为图像处理领域带来了全新的思路和方法。

相关链接

- 论文:http://arxiv.org/abs/2412.21079v2

- 主页:https://ezioby.github.io/edicho/

Edicho:实现跨图像一致编辑的新方法

一、引言

- 研究背景:在图像编辑领域,确保编辑内容在不同图像间的一致性是一个重要但具有挑战性的任务。内容创作者常常希望能够在多张照片上应用相同的编辑效果,如让多张照片中的人物都拥有相似的妆容或服装风格。

- 现有问题:以往的编辑方法往往基于单张图像进行处理,这导致了在不同图像间应用相同编辑时可能出现的不一致性和扭曲。

- Edicho提出:本文介绍的Edicho方法通过引入显式的对应关系预测,实现了跨图像的一致编辑,大大提高了编辑效率和质量。

二、相关工作

- 扩散模型的应用:近年来,扩散模型在图像生成和编辑领域取得了显著成果。通过空间对齐中间特征和融合无条件嵌入,扩散模型能够增强编辑的一致性。

- 基于范例的编辑:另一类工作是通过微调预训练的扩散模型,使其能够基于范例图像和掩码源图像进行编辑。这类方法虽然有效,但在处理野生图像时仍面临挑战。

三、方法概述

- 核心组件:Edicho方法主要包括两个核心组件:注意力操控模块和精心优化的无分类器指导(CFG)去噪策略。

- 注意力操控模块:该模块利用显式的对应关系预测来增强自注意力机制,确保编辑效果在不同图像间的一致性。

- CFG去噪策略:通过注入预计算的对应关系,指导两个级别的去噪过程:注意力特征和噪声潜变量。

- 显式对应关系预测:与隐式对应关系预测相比,显式对应关系更加准确和稳定,能够更好地处理野生图像间的内在变化。

四、实验验证

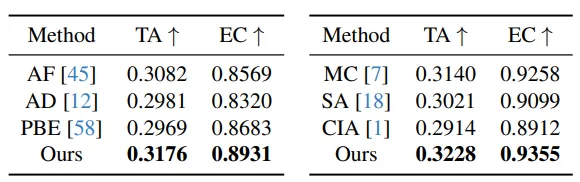

- 数据集与评估指标:实验采用了部分来自互联网和部分来自DreamBooth及Custom Diffusion数据集的样本,并使用CLIP模型进行文本对齐评估。

- 实验结果:Edicho方法在多种修改场景下均保持了输入图像的完整性,包括衣物纹理、面具和领口外观等。与基于隐式注意力的基线方法相比,Edicho在一致性和主题贴合度方面均表现出色。

五、应用示例

- 定制化生成:通过编辑,Edicho能够生成更加一致的图像集,这对于学习新颖概念的自定义模型和创建个性化内容具有重要价值。

- 新概念生成与编辑:通过引入低秩矩阵作为适应参数,微调后的生成模型能够根据编辑生成与期望相符的图像,从而实现新概念生成和编辑。

六、结论与展望

- 研究总结:本文提出的Edicho方法通过引入显式的对应关系预测,实现了跨图像的一致编辑。该方法增强了自注意力机制和无分类器指导计算,确保了编辑效果的一致性和高质量。

- 未来展望:随着技术的不断发展,Edicho方法有望在更多领域得到应用,如虚拟现实、增强现实以及图像修复等。同时,我们也期待更多创新方法的出现,共同推动图像编辑领域的发展。

文章来自:51CTO