腾讯混元团队发布了他们最新的力作——Hunyuan-TurboS,首个混合Transformer-Mamba MoE架构的超大模型

大家都知道,传统Transformer模型在处理长文本时一直面临挑战,O(N²)的复杂度以及KV-Cache问题让长文本训练和推理效率大打折扣。 而这次,混元-TurboS巧妙地融合了Mamba和Transformer两种架构的优势:

- • Mamba的高效长序列处理能力

- • Transformer强大的上下文理解能力

强强联合,效果自然惊艳!

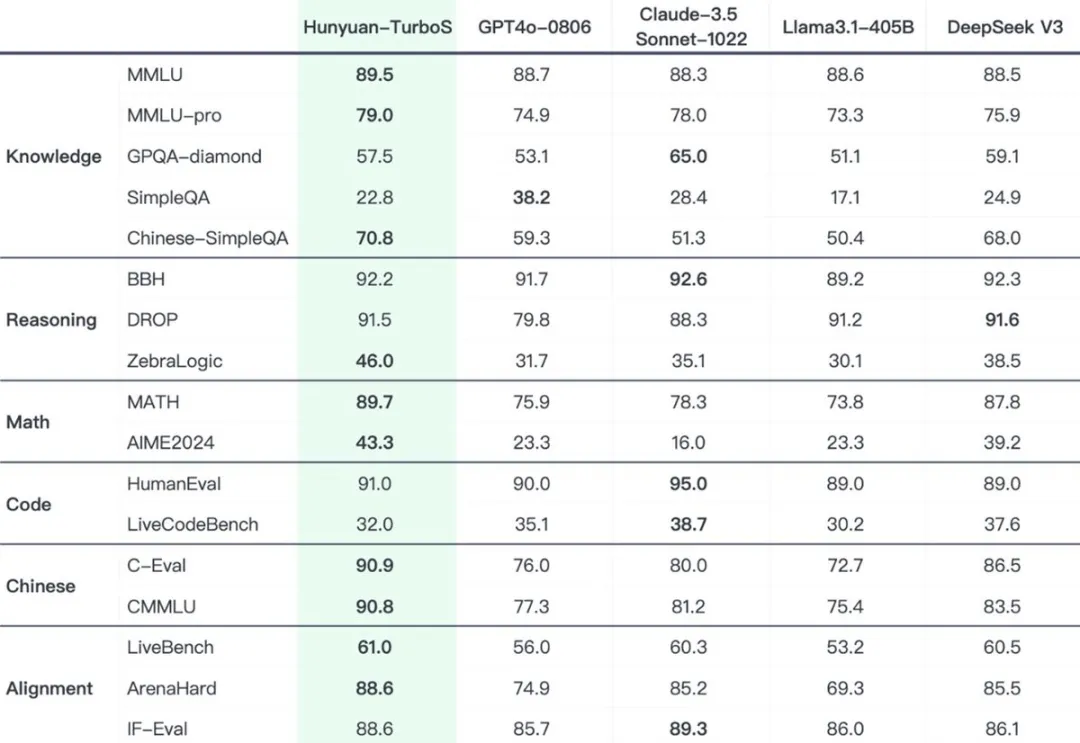

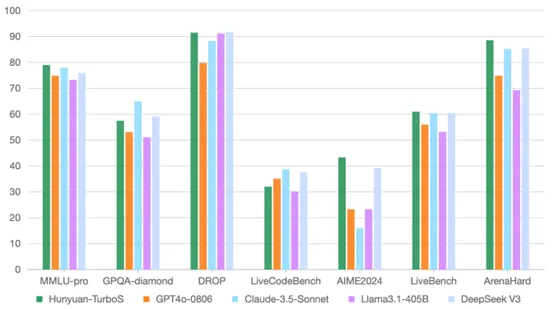

官方数据显示,Hunyuan-TurboS在多个关键benchmark上表现出色:

- • 数学、推理、对齐能力超越或持平 GPT-4o-0806、DeepSeek-V3 以及各类开源模型。

- • 知识能力同样突出,在 MMLU-Pro 等专业评测中也具备竞争力

Hunyuan-TurboS的推理成本相比之前的Turbo模型降低了整整7倍! 性能提升的同时,成本大幅下降

为了进一步提升模型能力,混元团队还对TurboS进行了多项后训练优化:

- • 引入慢思考(Slow-thinking)集成,显著提升了模型在数学、编程和推理任务上的表现。

- • 通过精细化的指令调优,增强了模型的对齐性和Agent执行能力。

- • 进行了英语训练优化,从而提升模型的通用性能。

除了模型架构和训练优化,混元团队还升级了奖励系统:

- • 采用基于规则的评分和一致性验证,保证模型输出的质量和可靠性。

- • 引入代码沙箱反馈,大幅提升模型在STEM领域的准确性。

- • 使用生成式奖励,优化模型在问答和创意性任务上的表现,并有效减少奖励作弊现象

写在最后:

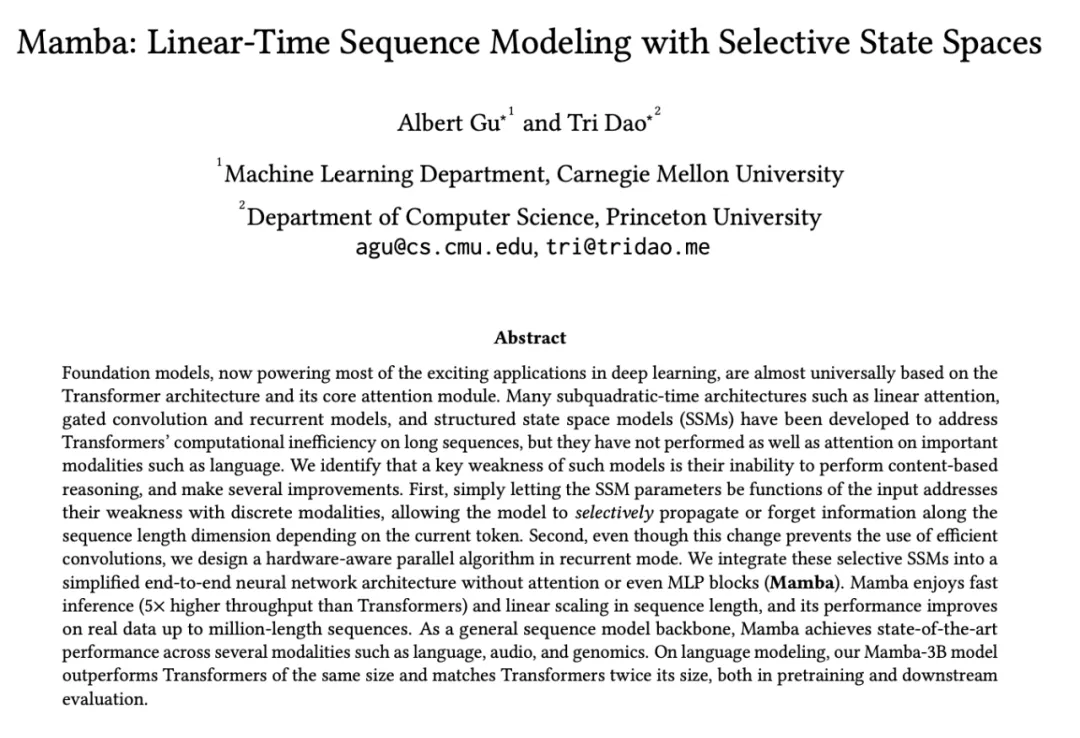

Mamba 是一种新型的状态空间模型 (State Space Model, SSM)。 简单来说,你可以把它理解为一种更高效处理长序列数据的模型架构,它主要为了解决 Transformer 模型在处理长序列时效率低下的问题而提出的

Mamba 是由 Albert Gu (卡耐基梅隆大学)和 Tri Dao(普林斯顿大学) 两位研究人员主导开发的

Mamba 的创新之处在于它引入了“选择性状态空间 (Selective State Spaces)” 的概念。 简单来说,Mamba 模型中的 SSM 参数不再是固定的,而是会根据输入的内容动态变化。 这样一来,模型就能根据当前处理的token,有选择性地记住或遗忘信息,从而更好地进行内容相关的推理

此外,Mamba 的设计也考虑了硬件效率,它在保持类似循环神经网络 (RNN) 的结构的同时,还能进行并行计算,这使得 Mamba 在推理速度上比 Transformer 更快(约快 5 倍)。 而且,Mamba 的计算复杂度是线性于序列长度的,这意味着处理更长的序列也不会显著增加计算负担

文章来自:51CTO