写在前面 & 笔者的个人理解

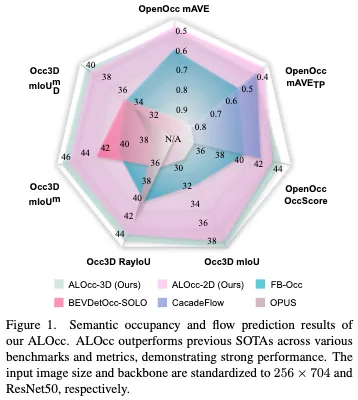

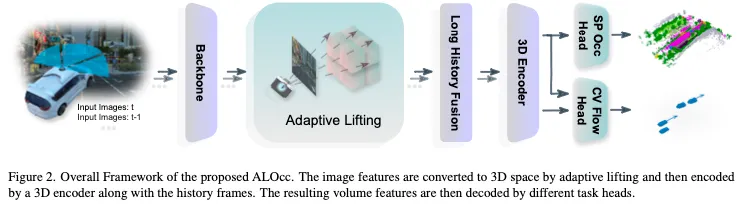

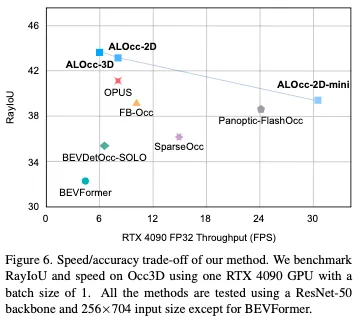

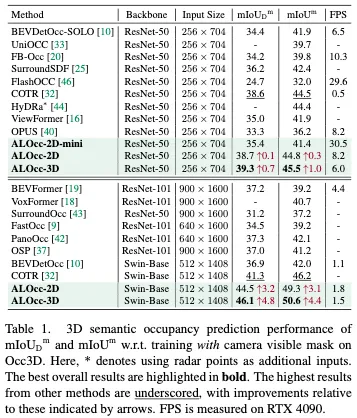

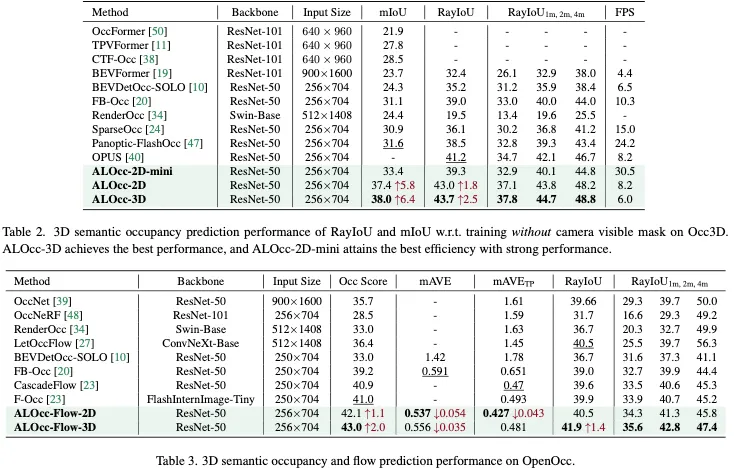

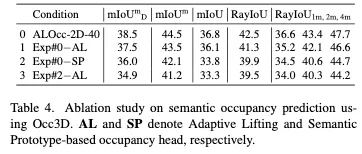

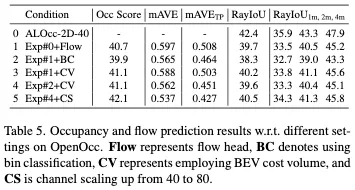

基于视觉的语义占用和流量预测在为自动驾驶等现实世界任务提供时空线索方面发挥着至关重要的作用。现有方法优先考虑更高的精度,以满足这些任务的需求。在这项工作中,通过引入一系列针对3D语义占用预测和流量估计的有针对性的改进来提高性能。首先引入了一种具有深度去噪技术的遮挡感知自适应提升机制,以提高二维到三维特征变换的鲁棒性,减少对深度先验的依赖。其次通过利用共享的语义原型来联合约束2D和3D特征,加强了3D特征与其原始2D模态之间的语义一致性。这与基于置信度和类别的采样策略相辅相成,以应对3D空间中的长尾挑战。为了减轻语义和流量联合预测中的特征编码负担,我们提出了一种基于BEV成本量的预测方法,该方法通过成本量将流量和语义特征联系起来,并采用分类回归监督方案来解决动态场景中不同的流量标度。本文的纯卷积架构框架名为ALOcc,在速度和精度之间实现了最佳权衡,在多个基准测试中取得了最先进的结果。在Occ3D和没有相机可见mask的训练中,我们的ALOcc在RayIoU方面实现了2.5%的绝对增益,同时使用相同的输入大小(256×704)和ResNet-50,以与SOTA速度相当的速度运行。ALOcc在CVPR24占用率和流量预测竞赛中也获得了第二名。

- 开源链接:https://github.com/cdb342/ALOcc

总结来说,本文的主要贡献如下:

- 介绍了一种二维到三维的自适应提升方法,该方法通过自适应权重调整将二维信号转换为遮挡和稀疏区域,同时结合深度去噪以防止收敛到局部最优值。

- 提出了一种基于BEV的成本量方法用于占用流量预测,减轻了多任务设置中的特征编码负担,并通过组合分类和回归增强了流量预测。

- 提出了共享语义原型,将类间关系从2D转移到3D,通过选择性原型训练和不确定性感知采样来缓解类不平衡问题。

- 对多个语义占用和流量预测基准的综合评估表明,与当前的SOTA相比,它有了持续的改进。我们提供多种模型变体,我们的实时版本优于现有的实时方法。

相关工作回顾

语义场景完成(SSC)致力于从给定的输入中重建和语义完成3D场景。早期的研究主要集中在室内场景,预测有限场景中的占用率和语义标签。随后的研究逐渐将注意力转移到复杂的户外环境,尤其是在驾驶环境中。SSC的本质是它能够感知未被观察到的事物,用精确的语义洞察力填补部分观察中的空白。最近的方法,如VoxFormer,采用了一种两阶段的方法,首先预测占用率,然后对占用的片段进行语义预测。OccFormer引入了一个用于3D编码的双路径Transformer子模块,并采用了一种基于查询的分割方法。

基于视觉的3D占用预测领域与SSC密切相关,但强调多视角联合感知,这对自主导航至关重要。占用率预测要求将复杂的3D场景描绘成细粒度的元素,以便熟练地导航动态驾驶环境。TPVFormer等最初的工作采用稀疏点云进行监督,利用空间注意力进行粒度预测。后续的工作,如OccNet、SurroundOcc、Occ3D和Openccupancy,基于时间信息和实例级标签构建了更密集的占用标注。一些研究借鉴了显式几何预测方法来促进二维到三维视图的转换。此外,最近的研究引入了3D占用流预测,该预测侧重于每体素动力学,扩展了3D场景理解的能力。然而,之前的研究缺乏一个连贯的评估框架,通常在孤立的基准(如Occ3D或Opencc)上进行实验,或者使用单一指标(如mIoU或RayIoU)比较性能。在这项工作中,我们提出了一种统一的方法,该方法在语义占用预测和占用流预测任务中都表现出色,并通过综合评估指标进行了验证。

ALOcc方法介绍

Revisiting Depth-based LSS

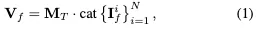

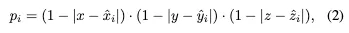

作为基于视觉的占用预测的核心模块,2D到3D视图转换过程可表述为:

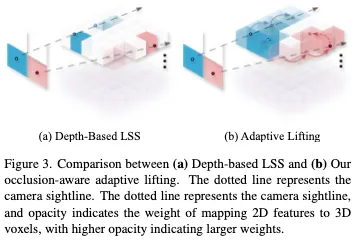

Occlusion-Aware Adaptive Lifting

我们通过引入从表面到遮挡区域的概率转移来增强基于深度的LSS。我们首先用基于概率的软填充方法取代了基于硬舍入的填充策略。如图3所示,我们使用三线性插值将点(x,y,z)的概率扩散到VCS中的八个相邻点上。插值计算八个概率值:

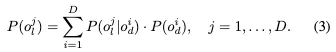

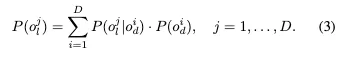

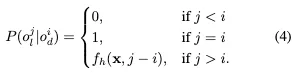

对于这两种情况,我们构建了一个从可见部分到遮挡部分的概率转移矩阵。对于前一种遮挡,我们设计了条件概率,将表面概率转化为遮挡长度概率。给定像素点x的离散深度概率,我们采用相同的bin划分进行离散遮挡长度预测。我们引入贝叶斯条件概率将离散深度概率转换为离散遮挡长度概率:

因此,我们只需要估计深度di到较大深度位置的条件概率。

深度概率在2D到3D语义转换中的主要作用可能会导致由于初始深度估计不准确而导致的次优模型收敛。为了减轻这种情况,我们引入了一种类似于目标检测算法中查询去噪的去噪操作。该方法利用GT深度概率来指导早期模型训练。我们采用GT和预测深度的加权平均值来指导训练中的自适应lifting过程。地面真实深度的权重初始化为1,并按照余弦退火策略逐渐减小到0。这可以表述为:

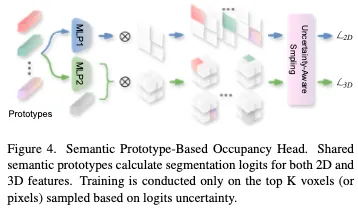

Semantic Prototype-based Occupancy Head

在2D到3D特征转换之后,我们使用共享原型增强了2D和3D特征之间的语义对齐。如图4所示,我们为每个类初始化一个语义原型,该原型同时作为2D和3D特征损失计算中的类权重。这种共享原型方法创建了一个链接2D和3D语义的快捷方式,促进了跨维度的一致特征表示。

给定每个类的原型,解码语义占用的直观方法是计算体素特征和原型之间的相似性,然后进行交叉熵监督。然而,由于驾驶场景中语义类别的高度倾斜分布,这种方法不是最优的。为了解决这种不平衡,我们提出了一种原型独立损失,该损失仅考虑每个场景的地面真实占用图中存在的类。

我们通过基础事实提取所有现有语义类别的原型(包括空类的嵌入),并计算这些原型和3D特征之间的内积以生成类掩码。为了进一步加强尾部类别的训练,我们采用了一种基于不确定性和类先验的采样技术。我们使用从内积导出的每原型logit图作为每体素不确定性的度量。这种不确定性和类先验形成多项式分布。然后,我们根据此分布从整个占用图中采样K个体素。损失仅在采样点上计算。最终的3D感知损失被表述为二进制交叉熵和diceA损失的组合:

BEV Cost Volume-based Occupancy Flow Prediction

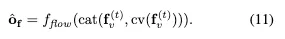

如图2所示,我们也从编码的体积特征中解码了占用流。基本上,流量网络将占用流量预测为:

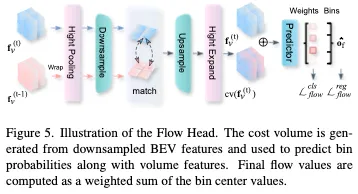

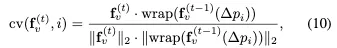

具体来说,我们对高度为0到4米的体积特征进行平均,以创建一个以前景为中心的BEV特征,如图5所示。我们对BEV特征进行降采样,以增加感受野,同时减少计算开销。然后,我们使用相机参数将前一帧的BEV特征包裹到当前帧的坐标系中,并在每个点周围的多个假设点处将其与当前帧特征进行匹配。通过计算每对特征之间的余弦相似度来构建成本量:

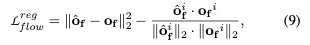

为了提高我们的模型预测不同尺度流量值的能力,我们提出了一种结合回归和分类的混合方法。我们根据从训练集中得出的最大和最小流量值将流量值划分为多个区间。我们的流量水头预测了流入每个料仓的流量的可能性。连续流量预测公式为bin中心值的加权和:

实验结果

结论

本文探讨了基于视觉的3D语义占用和流量预测的挑战。我们提出了一种基于遮挡感知的自适应提升方法,辅以深度去噪,以提高二维到三维视图转换过程的适应性和鲁棒性。为了进一步改进语义占用学习,我们引入了一种基于语义原型的占用头,该占用头将2D和3D语义对齐,并结合硬样本挖掘技术来缓解长尾问题。此外,我们提出了一种基于BEV成本量的方法来促进占用流学习,减少了同时表示语义和流的特征负担。对Occ3D和Opencc数据集进行的评估表明,我们的方法优于当前的SOTA解决方案。受益于我们方法的轻量级特性,我们提供了多种模型版本:我们性能最高的模型比其他性能相当的方法更快,而我们速度最快的模型比速度相似的方法具有更优的性能。

文章来自:51CTO